MySQL基础

1、初识MySQL

为什么学习数据库

1、岗位技能需求

2、现在的世界,得数据者得天下

3、存储数据的方法

4、程序,网站中,大量数据如何长久保存?

5、数据库是几乎软件体系中最核心的一个存在。

什么是数据库

数据库 ( DataBase , 简称DB )

概念 : 长期存放在计算机内,有组织,可共享的大量数据的集合,是一个数据 “仓库”

作用 : 保存,并能安全管理数据(如:增删改查等),减少冗余…

数据库总览 :

关系型数据库 ( SQL )

- MySQL , Oracle , SQL Server , SQLite , DB2 , …

- 关系型数据库通过外键关联来建立表与表之间的关系

非关系型数据库 ( NOSQL )

- Redis , MongoDB , …

- 非关系型数据库通常指数据以对象的形式存储在数据库中,而对象之间的关系通过每个对象自身的属性来决定

什么是DBMS

数据库管理系统 ( DataBase Management System )

数据库管理软件 , 科学组织和存储数据 , 高效地获取和维护数据

为什么要说这个呢?

因为我们要学习的MySQL应该算是一个数据库管理系统.

MySQL简介

概念 : 是现在流行的开源的,免费的 关系型数据库

历史 : 由瑞典MySQL AB 公司开发,目前属于 Oracle 旗下产品。

特点 :

- 免费 , 开源数据库

- 小巧 , 功能齐全

- 使用便捷

- 可运行于Windows或Linux操作系统

- 可适用于中小型甚至大型网站应用

安装MySQL

这里建议大家使用压缩版,安装快,方便.不复杂.

软件下载

mysql5.7 64位下载地址:

https://dev.mysql.com/get/Downloads/MySQL-5.7/mysql-5.7.19-winx64.zip

电脑是64位的就下载使用64位版本的!

安装步骤

1、下载后得到zip压缩包.

2、解压到自己想要安装到的目录,本人解压到的是D:\Environment\mysql-5.7.19

3、添加环境变量:我的电脑->属性->高级->环境变量

选择PATH,在其后面添加: 你的mysql 安装文件下面的bin文件夹4、编辑 my.ini 文件 ,注意替换路径位置

[mysqld]

basedir=D:\Program Files\mysql-5.7\

datadir=D:\Program Files\mysql-5.7\data\

port=3306

skip-grant-tables5、启动管理员模式下的CMD,并将路径切换至mysql下的bin目录,然后输入mysqld –install (安装mysql)

6、再输入 mysqld –initialize-insecure –user=mysql 初始化数据文件

7、然后再次启动mysql 然后用命令 mysql –u root –p 进入mysql管理界面(密码可为空)

8、进入界面后更改root密码

update mysql.user set authentication_string=password('123456') where user='root' and Host = 'localhost';9、刷新权限

flush privileges;10、修改 my.ini文件删除最后一句skip-grant-tables

11、重启mysql即可正常使用

net stop mysql

net start mysql12、连接上测试出现以下结果就安装好了

一步步去做 , 理论上是没有任何问题的 .

如果您以前装过,现在需要重装,一定要将环境清理干净 .

好了,到这里大家都装好了,因为刚接触,所以我们先不学习命令.

这里给大家推荐一个工具 : SQLyog .

即便有了可视化工具,可是基本的DOS命名大家还是要记住!

SQLyog

可手动操作,管理MySQL数据库的软件工具

特点 : 简洁 , 易用 , 图形化

使用SQLyog管理工具自己完成以下操作 :

连接本地MySQL数据库

新建MySchool数据库

- 字段

- GradeID : int(11) , Primary Key (pk)

- GradeName : varchar(50)

- 数据库名称MySchool

- 新建数据库表(grade)

在历史记录中可以看到相对应的数据库操作的语句 .

连接数据库

打开MySQL命令窗口

- 在DOS命令行窗口进入 安装目录\mysql\bin

- 可设置环境变量,设置了环境变量,可以在任意目录打开!

连接数据库语句 : mysql -h 服务器主机地址 -u 用户名 -p 用户密码

注意 : -p后面不能加空格,否则会被当做密码的内容,导致登录失败 !

几个基本的数据库操作命令 :

update user set password=password('123456')where user='root'; 修改密码

flush privileges; 刷新数据库

show databases; 显示所有数据库

use dbname;打开某个数据库

show tables; 显示数据库mysql中所有的表

describe user; 显示表mysql数据库中user表的列信息

create database name; 创建数据库

use databasename; 选择数据库

exit; 退出Mysql

? 命令关键词 : 寻求帮助

-- 表示注释2、数据库操作

结构化查询语句分类

数据库操作

命令行操作数据库

创建数据库 : create database [if not exists] 数据库名;

删除数据库 : drop database [if exists] 数据库名;

查看数据库 : show databases;

使用数据库 : use 数据库名;

对比工具操作数据库

学习方法:

- 对照SQLyog工具自动生成的语句学习

- 固定语法中的单词需要记忆

创建数据表

属于DDL的一种,语法 :

create table [if not exists] `表名`(

'字段名1' 列类型 [属性][索引][注释],

'字段名2' 列类型 [属性][索引][注释],

#...

'字段名n' 列类型 [属性][索引][注释]

)[表类型][表字符集][注释];说明 : 反引号用于区别MySQL保留字与普通字符而引入的 (键盘esc下面的键).

数据值和列类型

列类型 : 规定数据库中该列存放的数据类型

数值类型

字符串类型

日期和时间型数值类型

NULL值

- 理解为 “没有值” 或 “未知值”

- 不要用NULL进行算术运算 , 结果仍为NULL

数据字段属性

UnSigned

- 无符号的

- 声明该数据列不允许负数 .

ZEROFILL

- 0填充的

- 不足位数的用0来填充 , 如int(3),5则为005

Auto_InCrement

自动增长的 , 每添加一条数据 , 自动在上一个记录数上加 1(默认)

通常用于设置主键 , 且为整数类型

可定义起始值和步长

- 当前表设置步长(AUTO_INCREMENT=100) : 只影响当前表

- SET @@auto_increment_increment=5 ; 影响所有使用自增的表(全局)

NULL 和 NOT NULL

- 默认为NULL , 即没有插入该列的数值

- 如果设置为NOT NULL , 则该列必须有值

DEFAULT

- 默认的

- 用于设置默认值

- 例如,性别字段,默认为”男” , 否则为 “女” ; 若无指定该列的值 , 则默认值为”男”的值

-- 目标 : 创建一个school数据库

-- 创建学生表(列,字段)

-- 学号int 登录密码varchar(20) 姓名,性别varchar(2),出生日期(datatime),家庭住址,email

-- 创建表之前 , 一定要先选择数据库

CREATE TABLE IF NOT EXISTS `student` (

`id` int(4) NOT NULL AUTO_INCREMENT COMMENT '学号',

`name` varchar(30) NOT NULL DEFAULT '匿名' COMMENT '姓名',

`pwd` varchar(20) NOT NULL DEFAULT '123456' COMMENT '密码',

`sex` varchar(2) NOT NULL DEFAULT '男' COMMENT '性别',

`birthday` datetime DEFAULT NULL COMMENT '生日',

`address` varchar(100) DEFAULT NULL COMMENT '地址',

`email` varchar(50) DEFAULT NULL COMMENT '邮箱',

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8

-- 查看数据库的定义

SHOW CREATE DATABASE school;

-- 查看数据表的定义

SHOW CREATE TABLE student;

-- 显示表结构

DESC student; -- 设置严格检查模式(不能容错了)SET sql_mode='STRICT_TRANS_TABLES';数据表的类型

设置数据表的类型

CREATE TABLE 表名(

-- 省略一些代码

-- Mysql注释

-- 1. # 单行注释

-- 2. /*...*/ 多行注释

)ENGINE = MyISAM (or InnoDB)

-- 查看mysql所支持的引擎类型 (表类型)

SHOW ENGINES;MySQL的数据表的类型 : MyISAM , InnoDB , HEAP , BOB , CSV等…

常见的 MyISAM 与 InnoDB 类型:

经验 ( 适用场合 ) :

- 适用 MyISAM : 节约空间及相应速度

- 适用 InnoDB : 安全性 , 事务处理及多用户操作数据表

数据表的存储位置

MySQL数据表以文件方式存放在磁盘中

- 包括表文件 , 数据文件 , 以及数据库的选项文件

- 位置 : Mysql安装目录\data\下存放数据表 . 目录名对应数据库名 , 该目录下文件名对应数据表 .

注意 :

* . frm – 表结构定义文件

* . MYD – 数据文件 ( data )

* . MYI – 索引文件 ( index )

InnoDB类型数据表只有一个 *.frm文件 , 以及上一级目录的ibdata1文件

MyISAM类型数据表对应三个文件 :

设置数据表字符集

我们可为数据库,数据表,数据列设定不同的字符集,设定方法 :

- 创建时通过命令来设置 , 如 : CREATE TABLE 表名()CHARSET = utf8;

- 如无设定 , 则根据MySQL数据库配置文件 my.ini 中的参数设定

修改数据库

修改表 ( ALTER TABLE )

修改表名 :ALTER TABLE 旧表名 RENAME AS 新表名

添加字段 : ALTER TABLE 表名 ADD字段名 列属性[属性]

修改字段 :

- ALTER TABLE 表名 MODIFY 字段名 列类型[属性]

- ALTER TABLE 表名 CHANGE 旧字段名 新字段名 列属性[属性]

删除字段 : ALTER TABLE 表名 DROP 字段名

删除数据表

语法:DROP TABLE [IF EXISTS] 表名

- IF EXISTS为可选 , 判断是否存在该数据表

- 如删除不存在的数据表会抛出错误

其他

1. 可用反引号(`)为标识符(库名、表名、字段名、索引、别名)包裹,以避免与关键字重名!中文也可以作为标识符!

2. 每个库目录存在一个保存当前数据库的选项文件db.opt。

3. 注释:

单行注释 # 注释内容

多行注释 /* 注释内容 */

单行注释 -- 注释内容 (标准SQL注释风格,要求双破折号后加一空格符(空格、TAB、换行等))

4. 模式通配符:

_ 任意单个字符

% 任意多个字符,甚至包括零字符

单引号需要进行转义 \'

5. CMD命令行内的语句结束符可以为 ";", "\G", "\g",仅影响显示结果。其他地方还是用分号结束。delimiter 可修改当前对话的语句结束符。

6. SQL对大小写不敏感 (关键字)

7. 清除已有语句:\c3、MySQL数据管理

外键

外键概念

如果公共关键字在一个关系中是主关键字,那么这个公共关键字被称为另一个关系的外键。由此可见,外键表示了两个关系之间的相关联系。以另一个关系的外键作主关键字的表被称为主表,具有此外键的表被称为主表的从表。

在实际操作中,将一个表的值放入第二个表来表示关联,所使用的值是第一个表的主键值(在必要时可包括复合主键值)。此时,第二个表中保存这些值的属性称为外键(foreign key)。

外键作用

保持数据一致性,完整性,主要目的是控制存储在外键表中的数据,约束。使两张表形成关联,外键只能引用外表中的列的值或使用空值。

创建外键

建表时指定外键约束

-- 创建外键的方式一 : 创建子表同时创建外键

-- 年级表 (id\年级名称)

CREATE TABLE `grade` (

`gradeid` INT(10) NOT NULL AUTO_INCREMENT COMMENT '年级ID',

`gradename` VARCHAR(50) NOT NULL COMMENT '年级名称',

PRIMARY KEY (`gradeid`)

) ENGINE=INNODB DEFAULT CHARSET=utf8

-- 学生信息表 (学号,姓名,性别,年级,手机,地址,出生日期,邮箱,身份证号)

CREATE TABLE `student` (

`studentno` INT(4) NOT NULL COMMENT '学号',

`studentname` VARCHAR(20) NOT NULL DEFAULT '匿名' COMMENT '姓名',

`sex` TINYINT(1) DEFAULT '1' COMMENT '性别',

`gradeid` INT(10) DEFAULT NULL COMMENT '年级',

`phoneNum` VARCHAR(50) NOT NULL COMMENT '手机',

`address` VARCHAR(255) DEFAULT NULL COMMENT '地址',

`borndate` DATETIME DEFAULT NULL COMMENT '生日',

`email` VARCHAR(50) DEFAULT NULL COMMENT '邮箱',

`idCard` VARCHAR(18) DEFAULT NULL COMMENT '身份证号',

PRIMARY KEY (`studentno`),

KEY `FK_gradeid` (`gradeid`),

CONSTRAINT `FK_gradeid` FOREIGN KEY (`gradeid`) REFERENCES `grade` (`gradeid`)

) ENGINE=INNODB DEFAULT CHARSET=utf8建表后修改

-- 创建外键方式二 : 创建子表完毕后,修改子表添加外键

ALTER TABLE `student`

ADD CONSTRAINT `FK_gradeid` FOREIGN KEY (`gradeid`) REFERENCES `grade` (`gradeid`);删除外键

操作:删除 grade 表,发现报错

注意 : 删除具有主外键关系的表时 , 要先删子表 , 后删主表

-- 删除外键

ALTER TABLE student DROP FOREIGN KEY FK_gradeid;

-- 发现执行完上面的,索引还在,所以还要删除索引

-- 注:这个索引是建立外键的时候默认生成的

ALTER TABLE student DROP INDEX FK_gradeid;DML语言(CRUD)

数据库意义 : 数据存储、数据管理

管理数据库数据方法:

- 通过SQLyog等管理工具管理数据库数据

- 通过DML语句管理数据库数据

DML语言 :数据操作语言

用于操作数据库对象中所包含的数据

包括 :

- INSERT (添加数据语句)

- UPDATE (更新数据语句)

- DELETE (删除数据语句)

添加数据

INSERT命令

语法:

INSERT INTO 表名[(字段1,字段2,字段3,...)] VALUES('值1','值2','值3')注意 :

- 字段或值之间用英文逗号隔开 .

- ‘ 字段1,字段2…’ 该部分可省略 , 但添加的值务必与表结构,数据列,顺序相对应,且数量一致 .

- 可同时插入多条数据 , values 后用英文逗号隔开 .

-- 使用语句如何增加语句?

-- 语法 : INSERT INTO 表名[(字段1,字段2,字段3,...)] VALUES('值1','值2','值3')

INSERT INTO grade(gradename) VALUES ('大一');

-- 主键自增,那能否省略呢?

INSERT INTO grade VALUES ('大二');

-- 查询:INSERT INTO grade VALUE ('大二')错误代码:1136

Column count doesn`t match value count at row 1

-- 结论:'字段1,字段2...'该部分可省略 , 但添加的值务必与表结构,数据列,顺序相对应,且数量一致.

-- 一次插入多条数据

INSERT INTO grade(gradename) VALUES ('大三'),('大四');- 如果出现重复异常,希望捕获异常,使用insert into

- 如果出现重复异常,希望保存旧纪录,忽略新纪录,则使用insert ignore into

- 如果出现重复异常,希望更新指定字段,则使用insert into … on duplicate key update

- 如果出现重复异常,希望删除旧记录,插入新记录,则使用replace into

修改数据

update命令

语法:

UPDATE 表名 SET column_name=value [,column_name2=value2,...] [WHERE condition];注意 :

- column_name 为要更改的数据列

- value 为修改后的数据 , 可以为变量 , 具体指 , 表达式或者嵌套的SELECT结果

- condition 为筛选条件 , 如不指定则修改该表的所有列数据

where条件子句

可以简单的理解为 : 有条件地从表中筛选数据

测试:

-- 修改年级信息

UPDATE grade SET gradename = '高中' WHERE gradeid = 1;删除数据

DELETE命令

语法:

DELETE FROM 表名 [WHERE condition];注意:condition为筛选条件 , 如不指定则删除该表的所有列数据

-- 删除最后一个数据

DELETE FROM grade WHERE gradeid = 5TRUNCATE命令

作用:用于完全清空表数据 , 但表结构 , 索引 , 约束等不变 ;

语法:

TRUNCATE [TABLE] table_name;

-- 清空年级表

TRUNCATE grade注意:区别于DELETE命令

相同 : 都能删除数据 , 不删除表结构 , 但TRUNCATE速度更快

不同 :

- 使用TRUNCATE TABLE 重新设置AUTO_INCREMENT计数器

- 使用TRUNCATE TABLE不会对事务有影响 (事务后面会说)

测试:

-- 创建一个测试表

CREATE TABLE `test` (

`id` INT(4) NOT NULL AUTO_INCREMENT,

`coll` VARCHAR(20) NOT NULL,

PRIMARY KEY (`id`)

) ENGINE=INNODB DEFAULT CHARSET=utf8

-- 插入几个测试数据

INSERT INTO test(coll) VALUES('row1'),('row2'),('row3');

-- 删除表数据(不带where条件的delete)

DELETE FROM test;

-- 结论:如不指定Where则删除该表的所有列数据,自增当前值依然从原来基础上进行,会记录日志.

-- 删除表数据(truncate)

TRUNCATE TABLE test;

-- 结论:truncate删除数据,自增当前值会恢复到初始值重新开始;不会记录日志.

-- 同样使用DELETE清空不同引擎的数据库表数据.重启数据库服务后

-- InnoDB : 自增列从初始值重新开始 (因为是存储在内存中,断电即失)

-- MyISAM : 自增列依然从上一个自增数据基础上开始 (存在文件中,不会丢失)- 希望删除表结构时,用 drop;

- 希望保留表结构,但要删除所有记录时, 用 truncate;

- 希望保留表结构,但要删除部分记录时, 用 delete。

4、使用DQL查询数据(重点)

DQL语言

DQL( Data Query Language 数据查询语言 )

- 查询数据库数据 , 如SELECT语句

- 简单的单表查询或多表的复杂查询和嵌套查询

- 是数据库语言中最核心,最重要的语句

- 使用频率最高的语句

SELECT语法

SELECT [ALL | DISTINCT]

{* | table.* | [table.field1[as alias1][,table.field2[as alias2]][,...]]}

FROM table_name [as table_alias]

[left | right | inner join table_name2] -- 联合查询

[WHERE ...] -- 指定结果需满足的条件

[GROUP BY ...] -- 指定结果按照哪几个字段来分组

[HAVING] -- 过滤分组的记录必须满足的次要条件

[ORDER BY ...] -- 指定查询记录按一个或多个条件排序

[LIMIT {[offset,]row_count | row_countOFFSET offset}];

-- 指定查询的记录从哪条至哪条注意 : [ ] 括号代表可选的 , { }括号代表必选得

指定查询字段

-- 查询表中所有的数据列结果 , 采用 **" \* "** 符号; 但是效率低,不推荐 .

-- 查询所有学生信息

SELECT * FROM student;

-- 查询指定列(学号 , 姓名)

SELECT studentno,studentname FROM student;AS 子句作为别名

作用:

- 可给数据列取一个新别名

- 可给表取一个新别名

- 可把经计算或总结的结果用另一个新名称来代替

-- 这里是为列取别名(当然as关键词可以省略)

SELECT studentno AS 学号,studentname AS 姓名 FROM student;

-- 使用as也可以为表取别名

SELECT studentno AS 学号,studentname AS 姓名 FROM student AS s;

-- 使用as,为查询结果取一个新名字

-- CONCAT()函数拼接字符串

SELECT CONCAT('姓名:',studentname) AS 新姓名 FROM student;DISTINCT关键字的使用

作用 : 去掉SELECT查询返回的记录结果中重复的记录 ( 返回所有列的值都相同 ) , 只返回一条

-- # 查看哪些同学参加了考试(学号) 去除重复项

SELECT * FROM result; -- 查看考试成绩

SELECT studentno FROM result; -- 查看哪些同学参加了考试

SELECT DISTINCT studentno FROM result; -- 了解:DISTINCT 去除重复项 , (默认是ALL)使用表达式的列

数据库中的表达式 : 一般由文本值 , 列值 , NULL , 函数和操作符等组成

应用场景 :

SELECT语句返回结果列中使用

SELECT语句中的ORDER BY , HAVING等子句中使用

DML语句中的 where 条件语句中使用表达式

-- selcet查询中可以使用表达式 SELECT @@auto_increment_increment; -- 查询自增步长 SELECT VERSION(); -- 查询版本号 SELECT 100*3-1 AS 计算结果; -- 表达式 -- 学员考试成绩集体提分一分查看 SELECT studentno,StudentResult+1 AS '提分后' FROM result;避免SQL返回结果中包含 ‘ . ‘ , ‘ * ‘ 和括号等干扰开发语言程序.

where条件语句

作用:用于检索数据表中 符合条件 的记录

搜索条件可由一个或多个逻辑表达式组成 , 结果一般为真或假.

逻辑操作符

测试

-- 满足条件的查询(where)

SELECT Studentno,StudentResult FROM result;

-- 查询考试成绩在95-100之间的

SELECT Studentno,StudentResult

FROM result

WHERE StudentResult>=95 AND StudentResult<=100;

-- AND也可以写成 &&

SELECT Studentno,StudentResult

FROM result

WHERE StudentResult>=95 && StudentResult<=100;

-- 模糊查询(对应的词:精确查询)

SELECT Studentno,StudentResult

FROM result

WHERE StudentResult BETWEEN 95 AND 100;

-- 除了1000号同学,要其他同学的成绩

SELECT studentno,studentresult

FROM result

WHERE studentno!=1000;

-- 使用NOT

SELECT studentno,studentresult

FROM result

WHERE NOT studentno=1000;模糊查询 :比较操作符

注意:

- 数值数据类型的记录之间才能进行算术运算 ;

- 相同数据类型的数据之间才能进行比较 ;

测试:

-- 模糊查询 between and \ like \ in \ null

-- =============================================

-- LIKE

-- =============================================

-- 查询姓刘的同学的学号及姓名

-- like结合使用的通配符 : % (代表0到任意个字符) _ (一个字符)

SELECT studentno,studentname FROM student

WHERE studentname LIKE '刘%';

-- 查询姓刘的同学,后面只有一个字的

SELECT studentno,studentname FROM student

WHERE studentname LIKE '刘_';

-- 查询姓刘的同学,后面只有两个字的

SELECT studentno,studentname FROM student

WHERE studentname LIKE '刘__';

-- 查询姓名中含有 嘉 字的

SELECT studentno,studentname FROM student

WHERE studentname LIKE '%嘉%';

-- 查询姓名中含有特殊字符的需要使用转义符号 '\'

-- 自定义转义符关键字: ESCAPE ':'

-- =============================================

-- IN

-- =============================================

-- 查询学号为1000,1001,1002的学生姓名

SELECT studentno,studentname FROM student

WHERE studentno IN (1000,1001,1002);

-- 查询地址在北京,南京,河南洛阳的学生

SELECT studentno,studentname,address FROM student

WHERE address IN ('北京','南京','河南洛阳');

-- =============================================

-- NULL 空

-- =============================================

-- 查询出生日期没有填写的同学

-- 不能直接写=NULL , 这是代表错误的 , 用 is null

SELECT studentname FROM student

WHERE BornDate IS NULL;

-- 查询出生日期填写的同学

SELECT studentname FROM student

WHERE BornDate IS NOT NULL;

-- 查询没有写家庭住址的同学(空字符串不等于null)

SELECT studentname FROM student

WHERE Address='' OR Address IS NULL;连接查询

JOIN 对比

七种Join:https://www.runoob.com/w3cnote/sql-join-image-explain.html

测试

/*

连接查询

如需要多张数据表的数据进行查询,则可通过连接运算符实现多个查询

内连接 inner join

查询两个表中的结果集中的交集

外连接 outer join

左外连接 left join

(以左表作为基准,右边表来一一匹配,匹配不上的,返回左表的记录,右表以NULL填充)

右外连接 right join

(以右表作为基准,左边表来一一匹配,匹配不上的,返回右表的记录,左表以NULL填充)

等值连接和非等值连接

自连接

*/

-- 查询参加了考试的同学信息(学号,学生姓名,科目编号,分数)

SELECT * FROM student;

SELECT * FROM result;

/*思路:

(1):分析需求,确定查询的列来源于两个类,student result,连接查询

(2):确定使用哪种连接查询?(内连接)

*/

SELECT s.studentno,studentname,subjectno,StudentResult

FROM student s

INNER JOIN result r

ON r.studentno = s.studentno

-- 右连接(也可实现)

SELECT s.studentno,studentname,subjectno,StudentResult

FROM student s

RIGHT JOIN result r

ON r.studentno = s.studentno

-- 等值连接

SELECT s.studentno,studentname,subjectno,StudentResult

FROM student s , result r

WHERE r.studentno = s.studentno

-- 左连接 (查询了所有同学,不考试的也会查出来)

SELECT s.studentno,studentname,subjectno,StudentResult

FROM student s

LEFT JOIN result r

ON r.studentno = s.studentno

-- 查一下缺考的同学(左连接应用场景)

SELECT s.studentno,studentname,subjectno,StudentResult

FROM student s

LEFT JOIN result r

ON r.studentno = s.studentno

WHERE StudentResult IS NULL

-- 思考题:查询参加了考试的同学信息(学号,学生姓名,科目名,分数)

SELECT s.studentno,studentname,subjectname,StudentResult

FROM student s

INNER JOIN result r

ON r.studentno = s.studentno

INNER JOIN `subject` sub

ON sub.subjectno = r.subjectno自连接

/*

自连接

数据表与自身进行连接

需求:从一个包含栏目ID , 栏目名称和父栏目ID的表中

查询父栏目名称和其他子栏目名称

*/

-- 创建一个表

CREATE TABLE `category` (

`categoryid` INT(10) UNSIGNED NOT NULL AUTO_INCREMENT COMMENT '主题id',

`pid` INT(10) NOT NULL COMMENT '父id',

`categoryName` VARCHAR(50) NOT NULL COMMENT '主题名字',

PRIMARY KEY (`categoryid`)

) ENGINE=INNODB AUTO_INCREMENT=9 DEFAULT CHARSET=utf8

-- 插入数据

INSERT INTO `category` (`categoryid`, `pid`, `categoryName`)

VALUES('2','1','信息技术'),

('3','1','软件开发'),

('4','3','数据库'),

('5','1','美术设计'),

('6','3','web开发'),

('7','5','ps技术'),

('8','2','办公信息');

-- 编写SQL语句,将栏目的父子关系呈现出来 (父栏目名称,子栏目名称)

-- 核心思想:把一张表看成两张一模一样的表,然后将这两张表连接查询(自连接)

SELECT a.categoryName AS '父栏目',b.categoryName AS '子栏目'

FROM category AS a,category AS b

WHERE a.`categoryid`=b.`pid`

-- 思考题:查询参加了考试的同学信息(学号,学生姓名,科目名,分数)

SELECT s.studentno,studentname,subjectname,StudentResult

FROM student s

INNER JOIN result r

ON r.studentno = s.studentno

INNER JOIN `subject` sub

ON sub.subjectno = r.subjectno

-- 查询学员及所属的年级(学号,学生姓名,年级名)

SELECT studentno AS 学号,studentname AS 学生姓名,gradename AS 年级名称

FROM student s

INNER JOIN grade g

ON s.`GradeId` = g.`GradeID`

-- 查询科目及所属的年级(科目名称,年级名称)

SELECT subjectname AS 科目名称,gradename AS 年级名称

FROM SUBJECT sub

INNER JOIN grade g

ON sub.gradeid = g.gradeid

-- 查询 数据库结构-1 的所有考试结果(学号 学生姓名 科目名称 成绩)

SELECT s.studentno,studentname,subjectname,StudentResult

FROM student s

INNER JOIN result r

ON r.studentno = s.studentno

INNER JOIN `subject` sub

ON r.subjectno = sub.subjectno

WHERE subjectname='数据库结构-1'排序和分页

测试

/*============== 排序 ================

语法 : ORDER BY

ORDER BY 语句用于根据指定的列对结果集进行排序。

ORDER BY 语句默认按照ASC升序对记录进行排序。

如果您希望按照降序对记录进行排序,可以使用 DESC 关键字。

*/

-- 查询 数据库结构-1 的所有考试结果(学号 学生姓名 科目名称 成绩)

-- 按成绩降序排序

SELECT s.studentno,studentname,subjectname,StudentResult

FROM student s

INNER JOIN result r

ON r.studentno = s.studentno

INNER JOIN `subject` sub

ON r.subjectno = sub.subjectno

WHERE subjectname='数据库结构-1'

ORDER BY StudentResult DESC

/*============== 分页 ================

语法 : SELECT * FROM table LIMIT [offset,] rows | rows OFFSET offset

好处 : (用户体验,网络传输,查询压力)

推导:

第一页 : limit 0,5

第二页 : limit 5,5

第三页 : limit 10,5

......

第N页 : limit (pageNo-1)*pageSzie,pageSzie

[pageNo:页码,pageSize:单页面显示条数]

*/

-- 每页显示5条数据

SELECT s.studentno,studentname,subjectname,StudentResult

FROM student s

INNER JOIN result r

ON r.studentno = s.studentno

INNER JOIN `subject` sub

ON r.subjectno = sub.subjectno

WHERE subjectname='数据库结构-1'

ORDER BY StudentResult DESC , studentno

LIMIT 0,5

-- 查询 JAVA第一学年 课程成绩前10名并且分数大于80的学生信息(学号,姓名,课程名,分数)

SELECT s.studentno,studentname,subjectname,StudentResult

FROM student s

INNER JOIN result r

ON r.studentno = s.studentno

INNER JOIN `subject` sub

ON r.subjectno = sub.subjectno

WHERE subjectname='JAVA第一学年'

ORDER BY StudentResult DESC

LIMIT 0,10子查询

/*============== 子查询 ================

什么是子查询?

在查询语句中的WHERE条件子句中,又嵌套了另一个查询语句

嵌套查询可由多个子查询组成,求解的方式是由里及外;

子查询返回的结果一般都是集合,故而建议使用IN关键字;

*/

-- 查询 数据库结构-1 的所有考试结果(学号,科目编号,成绩),并且成绩降序排列

-- 方法一:使用连接查询

SELECT studentno,r.subjectno,StudentResult

FROM result r

INNER JOIN `subject` sub

ON r.`SubjectNo`=sub.`SubjectNo`

WHERE subjectname = '数据库结构-1'

ORDER BY studentresult DESC;

-- 方法二:使用子查询(执行顺序:由里及外)

SELECT studentno,subjectno,StudentResult

FROM result

WHERE subjectno=(

SELECT subjectno FROM `subject`

WHERE subjectname = '数据库结构-1'

)

ORDER BY studentresult DESC;

-- 查询课程为 高等数学-2 且分数不小于80分的学生的学号和姓名

-- 方法一:使用连接查询

SELECT s.studentno,studentname

FROM student s

INNER JOIN result r

ON s.`StudentNo` = r.`StudentNo`

INNER JOIN `subject` sub

ON sub.`SubjectNo` = r.`SubjectNo`

WHERE subjectname = '高等数学-2' AND StudentResult>=80

-- 方法二:使用连接查询+子查询

-- 分数不小于80分的学生的学号和姓名

SELECT r.studentno,studentname FROM student s

INNER JOIN result r ON s.`StudentNo`=r.`StudentNo`

WHERE StudentResult>=80

-- 在上面SQL基础上,添加需求:课程为 高等数学-2

SELECT r.studentno,studentname FROM student s

INNER JOIN result r ON s.`StudentNo`=r.`StudentNo`

WHERE StudentResult>=80 AND subjectno=(

SELECT subjectno FROM `subject`

WHERE subjectname = '高等数学-2'

)

-- 方法三:使用子查询

-- 分步写简单sql语句,然后将其嵌套起来

SELECT studentno,studentname FROM student WHERE studentno IN(

SELECT studentno FROM result WHERE StudentResult>=80 AND subjectno=(

SELECT subjectno FROM `subject` WHERE subjectname = '高等数学-2'

)

)

/*

练习题目:

查 C语言-1 的前5名学生的成绩信息(学号,姓名,分数)

使用子查询,查询郭靖同学所在的年级名称

*/5、MySQL函数

常用函数

数据函数

SELECT ABS(-8); /*绝对值*/

SELECT CEILING(9.4); /*向上取整*/

SELECT FLOOR(9.4); /*向下取整*/

SELECT RAND(); /*随机数,返回一个0-1之间的随机数*/

SELECT SIGN(0); /*符号函数: 负数返回-1,正数返回1,0返回0*/字符串函数

SELECT CHAR_LENGTH('狂神说坚持就能成功'); /*返回字符串包含的字符数*/

SELECT CONCAT('我','爱','程序'); /*合并字符串,参数可以有多个*/

SELECT INSERT('我爱编程helloworld',1,2,'超级热爱'); /*替换字符串,从某个位置开始替换某个长度*/

SELECT LOWER('KuangShen'); /*小写*/

SELECT UPPER('KuangShen'); /*大写*/

SELECT LEFT('hello,world',5); /*从左边截取*/

SELECT RIGHT('hello,world',5); /*从右边截取*/

SELECT REPLACE('狂神说坚持就能成功','坚持','努力'); /*替换字符串*/

SELECT SUBSTR('狂神说坚持就能成功',4,6); /*截取字符串,开始和长度*/

SELECT REVERSE('狂神说坚持就能成功'); /*反转

-- 查询姓周的同学,改成邹

SELECT REPLACE(studentname,'周','邹') AS 新名字

FROM student WHERE studentname LIKE '周%';日期和时间函数

SELECT CURRENT_DATE(); /*获取当前日期*/

SELECT CURDATE(); /*获取当前日期*/

SELECT now(); /*获取当前日期和时间*/

SELECT localtime(); /*获取当前日期和时间*/

SELECT sysdate(); /*获取当前日期和时间*/

select date_format(列名,'%Y%m%d')/*获取列的时间 ,参数2为日期格式*/

-- 获取年月日,时分秒

SELECT YEAR(NOW());

SELECT MONTH(NOW());

SELECT DAY(NOW());

SELECT HOUR(NOW());

SELECT MINUTE(NOW());

SELECT SECOND(NOW());

select date_add(now(), interval 1 year); //加1年

select date_add(now(), interval 1 month); //加1月

quarter:季,week:周,day:天,hour:小时,minuter:分钟,second:秒,microsecond:毫秒

注:也可以不用变量,直接加减某个时间,如:select date_add('1998-01-01', interval 1 day);

2.日期相减

datediff(date1,date2):两个日期相减,date1减去date2得到相减之后的天数

timediff(time1,time2):两个时间相减 time1减time2,返回差值。

select timediff('2019-06-03 12:30:00', '2019-06-03 12:29:30');

等同于

select timediff('12:30:00', '12:29:30');

系统信息函数

SELECT VERSION(); /*版本*/

SELECT USER(); /*用户*/

聚合函数

| 函数名称 | 描述 |

|---|---|

| COUNT() | 返回满足Select条件的记录总和数,如 select count(*) 【不建议使用 *,效率低】 |

| SUM() | 返回数字字段或表达式列作统计,返回一列的总和。 |

| AVG() | 通常为数值字段或表达列作统计,返回一列的平均值 |

| MAX() | 可以为数值字段,字符字段或表达式列作统计,返回最大的值。 |

| MIN() | 可以为数值字段,字符字段或表达式列作统计,返回最小的值。 |

-- 聚合函数

/*COUNT:非空的*/

SELECT COUNT(studentname) FROM student;

SELECT COUNT(*) FROM student;

SELECT COUNT(1) FROM student; /*推荐*/

-- 从含义上讲,count(1) 与 count(*) 都表示对全部数据行的查询。

-- count(字段) 会统计该字段在表中出现的次数,忽略字段为null 的情况。即不统计字段为null 的记录。

-- count(*) 包括了所有的列,相当于行数,在统计结果的时候,包含字段为null 的记录;

-- count(1) 用1代表代码行,在统计结果的时候,包含字段为null 的记录 。

/*

很多人认为count(1)执行的效率会比count(*)高,原因是count(*)会存在全表扫描,而count(1)可以针对一个字段进行查询。其实不然,count(1)和count(*)都会对全表进行扫描,统计所有记录的条数,包括那些为null的记录,因此,它们的效率可以说是相差无几。而count(字段)则与前两者不同,它会统计该字段不为null的记录条数。

下面它们之间的一些对比:

1)在表没有主键时,count(1)比count(*)快

2)有主键时,主键作为计算条件,count(主键)效率最高;

3)若表格只有一个字段,则count(*)效率较高。

*/

SELECT SUM(StudentResult) AS 总和 FROM result;

SELECT AVG(StudentResult) AS 平均分 FROM result;

SELECT MAX(StudentResult) AS 最高分 FROM result;

SELECT MIN(StudentResult) AS 最低分 FROM result;题目:

-- 查询不同课程的平均分,最高分,最低分

-- 前提:根据不同的课程进行分组

SELECT subjectname,AVG(studentresult) AS 平均分,MAX(StudentResult) AS 最高分,MIN(StudentResult) AS 最低分

FROM result AS r

INNER JOIN `subject` AS s

ON r.subjectno = s.subjectno

GROUP BY r.subjectno

HAVING 平均分>80;

/*

where写在group by前面.

要是放在分组后面的筛选

要使用HAVING..

因为having是从前面筛选的字段再筛选,而where是从数据表中的>字段直接进行的筛选的

*/MD5 加密

一、MD5简介

MD5即Message-Digest Algorithm 5(信息-摘要算法5),用于确保信息传输完整一致。是计算机广泛使用的杂凑算法之一(又译摘要算法、哈希算法),主流编程语言普遍已有MD5实现。将数据(如汉字)运算为另一固定长度值,是杂凑算法的基础原理,MD5的前身有MD2、MD3和MD4。

二、实现数据加密

新建一个表 testmd5

CREATE TABLE `testmd5` (

`id` INT(4) NOT NULL,

`name` VARCHAR(20) NOT NULL,

`pwd` VARCHAR(50) NOT NULL,

PRIMARY KEY (`id`)

) ENGINE=INNODB DEFAULT CHARSET=utf8插入一些数据

INSERT INTO testmd5 VALUES(1,'kuangshen','123456'),(2,'qinjiang','456789')如果我们要对pwd这一列数据进行加密,语法是:

update testmd5 set pwd = md5(pwd);如果单独对某个用户(如kuangshen)的密码加密:

INSERT INTO testmd5 VALUES(3,'kuangshen2','123456')

update testmd5 set pwd = md5(pwd) where name = 'kuangshen2';插入新的数据自动加密

INSERT INTO testmd5 VALUES(4,'kuangshen3',md5('123456'));查询登录用户信息(md5对比使用,查看用户输入加密后的密码进行比对)

SELECT * FROM testmd5 WHERE `name`='kuangshen' AND pwd=MD5('123456');小结

-- ================ 内置函数 ================

-- 数值函数

abs(x) -- 绝对值 abs(-10.9) = 10

format(x, d) -- 格式化千分位数值 format(1234567.456, 2) = 1,234,567.46

ceil(x) -- 向上取整 ceil(10.1) = 11

floor(x) -- 向下取整 floor (10.1) = 10

round(x) -- 四舍五入去整

mod(m, n) -- m%n m mod n 求余 10%3=1

pi() -- 获得圆周率

pow(m, n) -- m^n

sqrt(x) -- 算术平方根

rand() -- 随机数

truncate(x, d) -- 截取d位小数

-- 时间日期函数

now(), current_timestamp(); -- 当前日期时间

current_date(); -- 当前日期

current_time(); -- 当前时间

date('yyyy-mm-dd hh:ii:ss'); -- 获取日期部分

time('yyyy-mm-dd hh:ii:ss'); -- 获取时间部分

date_format('yyyy-mm-dd hh:ii:ss', '%d %y %a %d %m %b %j'); -- 格式化时间

unix_timestamp(); -- 获得unix时间戳

from_unixtime(); -- 从时间戳获得时间

-- 字符串函数

length(string) -- string长度,字节

char_length(string) -- string的字符个数

substring(str, position [,length]) -- 从str的position开始,取length个字符

replace(str ,search_str ,replace_str) -- 在str中用replace_str替换search_str

instr(string ,substring) -- 返回substring首次在string中出现的位置

concat(string [,...]) -- 连接字串

charset(str) -- 返回字串字符集

lcase(string) -- 转换成小写

left(string, length) -- 从string2中的左边起取length个字符

load_file(file_name) -- 从文件读取内容

locate(substring, string [,start_position]) -- 同instr,但可指定开始位置

lpad(string, length, pad) -- 重复用pad加在string开头,直到字串长度为length

ltrim(string) -- 去除前端空格

repeat(string, count) -- 重复count次

rpad(string, length, pad) --在str后用pad补充,直到长度为length

rtrim(string) -- 去除后端空格

strcmp(string1 ,string2) -- 逐字符比较两字串大小

-- 聚合函数

count()

sum();

max();

min();

avg();

group_concat()

-- 其他常用函数

md5();

default();事务和索引

事务

什么是事务(例如转账)

- 事务就是将一组SQL语句放在同一批次内去执行

- 如果一个SQL语句出错,则该批次内的所有SQL都将被取消执行

- MySQL事务处理只支持InnoDB和BDB数据表类型

事务管理(ACID原则)

原子性(Atomicity)

原子性是指事务是一个不可分割的工作单位,整个事务中的所有操作,要么全部完成,要么全部不完成,不可能停滞在中间某个环节。事务在执行过程中发生错误,会被回滚(ROLLBACK)到事务开始前的状态,就像这个事务从来没有执行过一样

一致性(Consistency)

事务前后数据的完整性必须保持一致。一个事务可以封装状态改变(除非它是一个只读的)。事务必须始终保持系统处于一致的状态,不管在任何给定的时间并发事务有多少。也就是说:如果事务是并发多个,系统也必须如同串行事务一样操作。其主要特征是保护性和不变性(Preserving an Invariant),

隔离性(Isolation)

事务的隔离性是多个用户并发访问数据库时,数据库为每一个用户开启的事务,不能被其他事务的操作数据所干扰,多个并发事务之间要相互隔离。

持久性(Durability)

持久性是指一个事务一旦被提交,它对数据库中数据的改变就是永久性的,接下来即使数据库发生故障也不应该对其有任何影响

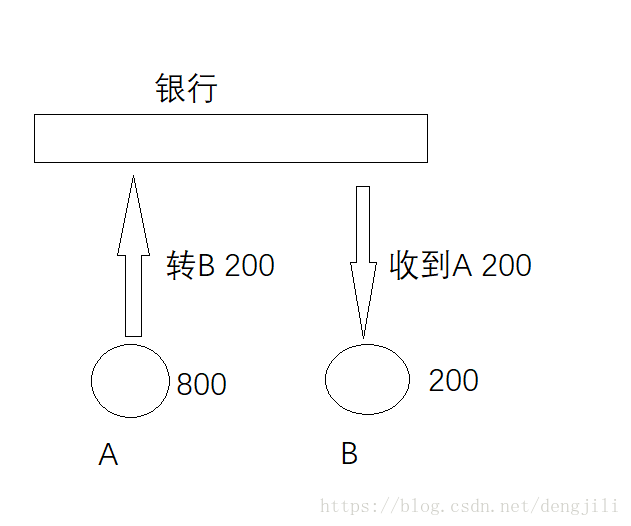

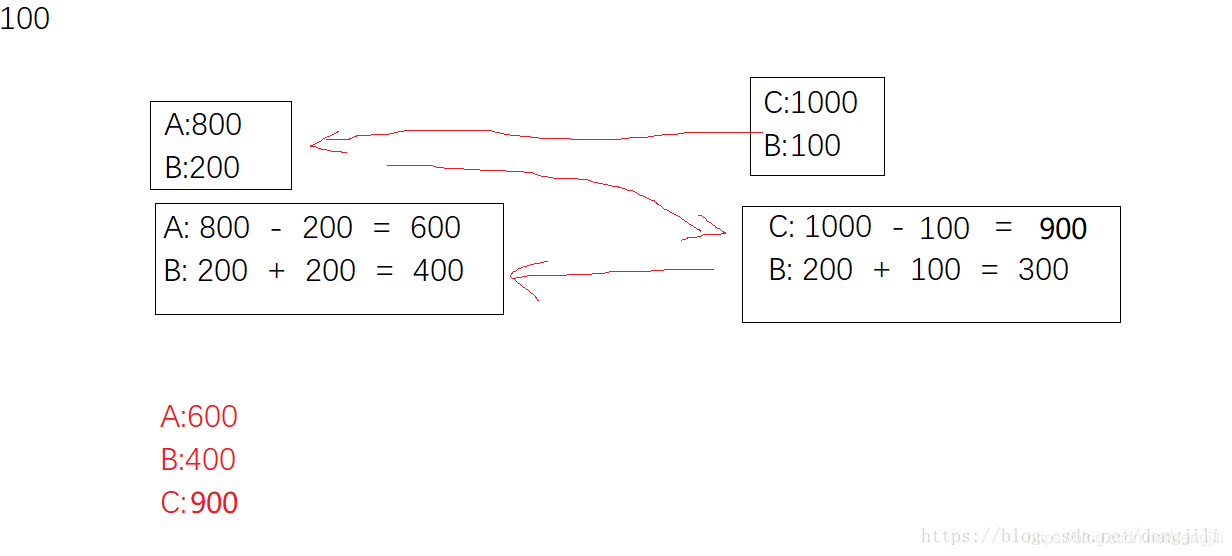

举个简单的例子理解以上四点

原子性

针对同一个事务

这个过程包含两个步骤

A: 800 - 200 = 600

B: 200 + 200 = 400

原子性表示,这两个步骤一起成功,或者一起失败,不能只发生其中一个动作

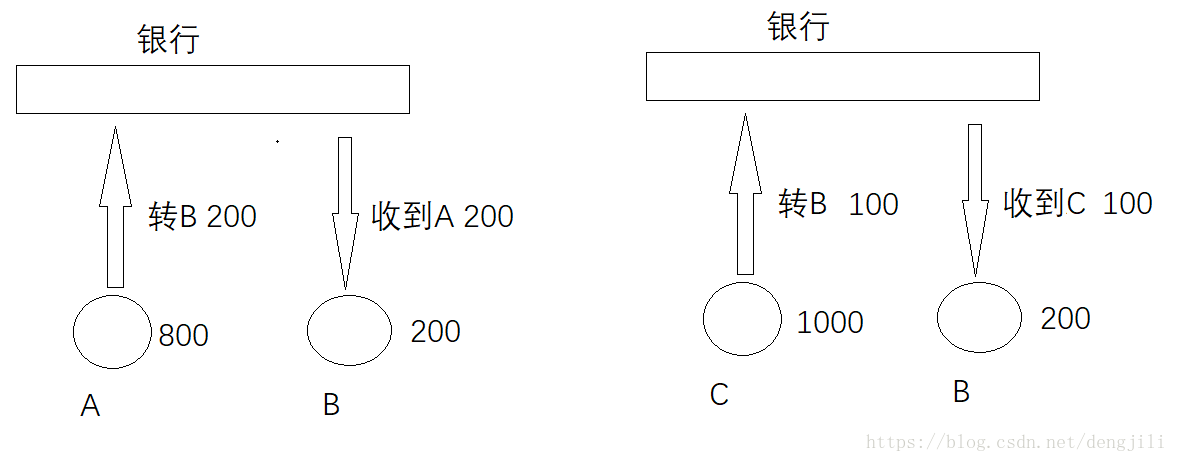

一致性(Consistency)

针对一个事务操作前与操作后的状态一致

操作前A:800,B:200

操作后A:600,B:400

一致性表示事务完成后,符合逻辑运算

持久性(Durability)

表示事务结束后的数据不随着外界原因导致数据丢失

操作前A:800,B:200

操作后A:600,B:400

如果在操作前(事务还没有提交)服务器宕机或者断电,那么重启数据库以后,数据状态应该为

A:800,B:200

如果在操作后(事务已经提交)服务器宕机或者断电,那么重启数据库以后,数据状态应该为

A:600,B:400

隔离性(Isolation)

针对多个用户同时操作,主要是排除其他事务对本次事务的影响

两个事务同时进行,其中一个事务读取到另外一个事务还没有提交的数据,B

脏读:

指一个事务读取了另外一个事务未提交的数据。

不可重复读:

在一个事务内读取表中的某一行数据,多次读取结果不同。(这个不一定是错误,只是某些场合不对)

页面统计查询值

点击生成报表的时候,B有人转账进来300(事务已经提交)

虚读(幻读)

是指在一个事务内读取到了别的事务插入的数据,导致前后读取不一致。

(一般是行影响,多了一行)

事务基本语法

-- 使用set语句来改变自动提交模式

SET autocommit = 0; /*关闭*/

SET autocommit = 1; /*开启*/

-- 注意:

--- 1.MySQL中默认是自动提交

--- 2.使用事务时应先关闭自动提交

SET autocommit = 0; /*关闭*/

-- 开始一个事务,标记事务的起始点

START TRANSACTION

-- 提交一个事务给数据库 持久化(事务成功)

COMMIT

-- 将事务回滚,数据回到本次事务的初始状态 (事务失败)

ROLLBACK

-- 还原MySQL数据库的自动提交

SET autocommit =1;

-- 保存点

SAVEPOINT 保存点名称 -- 设置一个事务保存点

ROLLBACK TO SAVEPOINT 保存点名称 -- 回滚到保存点

RELEASE SAVEPOINT 保存点名称 -- 删除保存点四种隔离级别设置

####数据库

set transaction isolation level 设置事务隔离级别

select @@tx_isolation 查询当前事务隔离级别

| 设置 | 描述 |

|---|---|

| Serializable | 可避免脏读、不可重复读、虚读情况的发生。(串行化) |

| Repeatable read | 可避免脏读、不可重复读情况的发生。(可重复读) |

| Read committed | 可避免脏读情况发生(读已提交)。 |

| Read uncommitted | 最低级别,以上情况均无法保证。(读未提交) |

java

适当的 Connection 方法,比如 setAutoCommit 或 setTransactionIsolation

| 设置 | 描述 |

|---|---|

| TRANSACTION_SERIALIZABLE | 指示不可以发生脏读、不可重复读和虚读的常量。 |

| TRANSACTION_REPEATABLE_READ | 指示不可以发生脏读和不可重复读的常量;虚读可以发生。 |

| TRANSACTION_READ_UNCOMMITTED | 指示可以发生脏读 (dirty read)、不可重复读和虚读 (phantom read) 的常量。 |

| TRANSACTION_READ_COMMITTED | 指示不可以发生脏读的常量;不可重复读和虚读可以发生。 |

mysql模拟事务隔离性测试

SELECT @@session.tx_isolation;

SELECT @@tx_isolation;

SET SESSION TRANSACTION ISOLATION LEVEL read uncommitted;

SET SESSION TRANSACTION ISOLATION LEVEL read committed;

SET SESSION TRANSACTION ISOLATION LEVEL repeatable read;

SET SESSION TRANSACTION ISOLATION LEVEL serializable;

start transaction;

--建表

drop table AMOUNT;

CREATE TABLE `AMOUNT` (

`id` varchar(10) NULL,

`money` numeric NULL

)

;

--插入数据

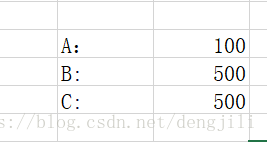

insert into amount(id,money) values('A', 800);

insert into amount(id,money) values('B', 200);

insert into amount(id,money) values('C', 1000);

--测试可重复读,插入数据

insert into amount(id,money) values('D', 1000);

--设置事务

SET SESSION TRANSACTION ISOLATION LEVEL read uncommitted;

SELECT @@tx_isolation;

--开启事务

start transaction;

--脏读演示,读到其他事务未提交的数据

--案列1,事务一:A向B转200,事务二:查看B金额变化,事务一回滚事务

update amount set money = money - 200 where id = 'A';

update amount set money = money + 200 where id = 'B';

--不可重复读演示,读到了其他事务提交的数据

--案列2,事务一:B向A转200,事务二:B向C转200转100

SET SESSION TRANSACTION ISOLATION LEVEL read committed;

--开启事务

start transaction;

--两个事务都查一下数据(转账之前需要,查一下金额是否够满足转账)

select * from amount;

--事务一:B向A转200

update amount set money = money - 200 where id = 'B';

update amount set money = money + 200 where id = 'A';

commit;

--事务二:B向C转200转100

update amount set money = money - 100 where id = 'B';

update amount set money = money + 100 where id = 'C';

commit;

--从事务二的角度来看,读到了事务一提交事务的数据,导致金额出现负数

--幻读演示

--案列3,事务一:B向A转200,事务二:B向C转200转100

SET SESSION TRANSACTION ISOLATION LEVEL repeatable read;

--开启事务

start transaction;

--两个事务都查一下数据(转账之前需要,查一下金额是否够满足转账)

select * from amount;

--事务一:B向A转200

update amount set money = money - 200 where id = 'B';

update amount set money = money + 200 where id = 'A';

commit;

--事务二:B向C转200转100

update amount set money = money - 100 where id = 'B';

update amount set money = money + 100 where id = 'C';

commit;

--从事务二的角度来看,读到了事务一提交事务的数据,导致金额出现负数- serializable事务二会一直等着事务一提交再操作

测试

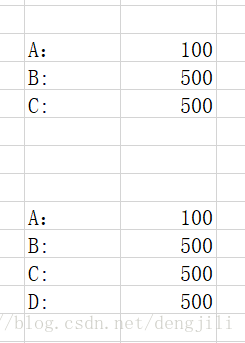

/*

课堂测试题目

A在线买一款价格为500元商品,网上银行转账.

A的银行卡余额为2000,然后给商家B支付500.

商家B一开始的银行卡余额为10000

创建数据库shop和创建表account并插入2条数据

*/

CREATE DATABASE `shop`CHARACTER SET utf8 COLLATE utf8_general_ci;

USE `shop`;

CREATE TABLE `account` (

`id` INT(11) NOT NULL AUTO_INCREMENT,

`name` VARCHAR(32) NOT NULL,

`cash` DECIMAL(9,2) NOT NULL,

PRIMARY KEY (`id`)

) ENGINE=INNODB DEFAULT CHARSET=utf8

INSERT INTO account (`name`,`cash`)

VALUES('A',2000.00),('B',10000.00)

-- 转账实现

SET autocommit = 0; -- 关闭自动提交

START TRANSACTION; -- 开始一个事务,标记事务的起始点

UPDATE account SET cash=cash-500 WHERE `name`='A';

UPDATE account SET cash=cash+500 WHERE `name`='B';

COMMIT; -- 提交事务

# rollback;

SET autocommit = 1; -- 恢复自动提交索引

索引的作用

- 提高查询速度

- 确保数据的唯一性

- 可以加速表和表之间的连接 , 实现表与表之间的参照完整性

- 使用分组和排序子句进行数据检索时 , 可以显著减少分组和排序的时间

- 全文检索字段进行搜索优化.

分类

- 主键索引 (Primary Key)

- 唯一索引 (Unique)

- 常规索引 (Index)

- 全文索引 (FullText)

主键索引

主键 : 某一个属性组能唯一标识一条记录

特点 :

- 最常见的索引类型

- 确保数据记录的唯一性

- 确定特定数据记录在数据库中的位置

唯一索引

作用 : 避免同一个表中某数据列中的值重复

与主键索引的区别

- 主键索引只能有一个

- 唯一索引可能有多个

CREATE TABLE `Grade`(

`GradeID` INT(11) AUTO_INCREMENT PRIMARYKEY,

`GradeName` VARCHAR(32) NOT NULL UNIQUE

-- 或 UNIQUE KEY `GradeID` (`GradeID`)

)常规索引

作用 : 快速定位特定数据

注意 :

- index 和 key 关键字都可以设置常规索引

- 应加在查询找条件的字段

- 不宜添加太多常规索引,影响数据的插入,删除和修改操作

CREATE TABLE `result`(

-- 省略一些代码

INDEX/KEY `ind` (`studentNo`,`subjectNo`) -- 创建表时添加

)

-- 创建后添加

ALTER TABLE `result` ADD INDEX `ind`(`studentNo`,`subjectNo`);全文索引

百度搜索:全文索引

作用 : 快速定位特定数据

注意 :

- 只能用于MyISAM类型的数据表

- 只能用于CHAR , VARCHAR , TEXT数据列类型

- 适合大型数据集

/*

#方法一:创建表时

CREATE TABLE 表名 (

字段名1 数据类型 [完整性约束条件…],

字段名2 数据类型 [完整性约束条件…],

[UNIQUE | FULLTEXT | SPATIAL ] INDEX | KEY

[索引名] (字段名[(长度)] [ASC |DESC])

);

#方法二:CREATE在已存在的表上创建索引

CREATE [UNIQUE | FULLTEXT | SPATIAL ] INDEX 索引名

ON 表名 (字段名[(长度)] [ASC |DESC]) ;

#方法三:ALTER TABLE在已存在的表上创建索引

ALTER TABLE 表名 ADD [UNIQUE | FULLTEXT | SPATIAL ] INDEX

索引名 (字段名[(长度)] [ASC |DESC]) ;

#删除索引:DROP INDEX 索引名 ON 表名字;

#删除主键索引: ALTER TABLE 表名 DROP PRIMARY KEY;

#显示索引信息: SHOW INDEX FROM student;

*/

/*增加全文索引*/

ALTER TABLE `school`.`student` ADD FULLTEXT INDEX `studentname` (`StudentName`);

/*EXPLAIN : 分析SQL语句执行性能*/

EXPLAIN SELECT * FROM student WHERE studentno='1000';

/*使用全文索引*/

-- 全文搜索通过 MATCH() 函数完成。

-- 搜索字符串作为 against() 的参数被给定。搜索以忽略字母大小写的方式执行。对于表中的每个记录行,MATCH() 返回一个相关性值。即,在搜索字符串与记录行在 MATCH() 列表中指定的列的文本之间的相似性尺度。

EXPLAIN SELECT *FROM student WHERE MATCH(studentname) AGAINST('love');

/*

开始之前,先说一下全文索引的版本、存储引擎、数据类型的支持情况

MySQL 5.6 以前的版本,只有 MyISAM 存储引擎支持全文索引;

MySQL 5.6 及以后的版本,MyISAM 和 InnoDB 存储引擎均支持全文索引;

只有字段的数据类型为 char、varchar、text 及其系列才可以建全文索引。

测试或使用全文索引时,要先看一下自己的 MySQL 版本、存储引擎和数据类型是否支持全文索引。

*/拓展:测试索引

建表app_user:

CREATE TABLE `app_user` (

`id` bigint(20) unsigned NOT NULL AUTO_INCREMENT,

`name` varchar(50) DEFAULT '' COMMENT '用户昵称',

`email` varchar(50) NOT NULL COMMENT '用户邮箱',

`phone` varchar(20) DEFAULT '' COMMENT '手机号',

`gender` tinyint(4) unsigned DEFAULT '0' COMMENT '性别(0:男;1:女)',

`password` varchar(100) NOT NULL COMMENT '密码',

`age` tinyint(4) DEFAULT '0' COMMENT '年龄',

`create_time` datetime DEFAULT CURRENT_TIMESTAMP,

`update_time` timestamp NULL DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP,

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COMMENT='app用户表'批量插入数据:100w

DROP FUNCTION IF EXISTS mock_data;

DELIMITER $$

CREATE FUNCTION mock_data()

RETURNS INT

BEGIN

DECLARE num INT DEFAULT 1000000;

DECLARE i INT DEFAULT 0;

WHILE i < num DO

INSERT INTO app_user(`name`, `email`, `phone`, `gender`, `password`, `age`)

VALUES(CONCAT('用户', i), '24736743@qq.com', CONCAT('18', FLOOR(RAND()*(999999999-100000000)+100000000)),FLOOR(RAND()*2),UUID(), FLOOR(RAND()*100));

SET i = i + 1;

END WHILE;

RETURN i;

END;

SELECT mock_data();索引效率测试

无索引

SELECT * FROM app_user WHERE name = '用户9999'; -- 查看耗时

SELECT * FROM app_user WHERE name = '用户9999';

SELECT * FROM app_user WHERE name = '用户9999';

mysql> EXPLAIN SELECT * FROM app_user WHERE name = '用户9999'\G

*************************** 1. row ***************************

id: 1

select_type: SIMPLE

table: app_user

partitions: NULL

type: ALL

possible_keys: NULL

key: NULL

key_len: NULL

ref: NULL

rows: 992759

filtered: 10.00

Extra: Using where

1 row in set, 1 warning (0.00 sec)创建索引

CREATE INDEX idx_app_user_name ON app_user(name);测试普通索引

mysql> EXPLAIN SELECT * FROM app_user WHERE name = '用户9999'\G

*************************** 1. row ***************************

id: 1

select_type: SIMPLE

table: app_user

partitions: NULL

type: ref

possible_keys: idx_app_user_name

key: idx_app_user_name

key_len: 203

ref: const

rows: 1

filtered: 100.00

Extra: NULL

1 row in set, 1 warning (0.00 sec)

mysql> SELECT * FROM app_user WHERE name = '用户9999';

1 row in set (0.00 sec)

mysql> SELECT * FROM app_user WHERE name = '用户9999';

1 row in set (0.00 sec)

mysql> SELECT * FROM app_user WHERE name = '用户9999';

1 row in set (0.00 sec)索引准则

- 索引不是越多越好

- 不要对经常变动的数据加索引

- 小数据量的表建议不要加索引

- 索引一般应加在查找条件的字段

索引的数据结构

阅读: https://blog.csdn.net/qq_36381855/article/details/80011876

-- 我们可以在创建上述索引的时候,为其指定索引类型,分两类

hash类型的索引:查询单条快,范围查询慢

btree类型的索引:b+树,层数越多,数据量指数级增长(我们就用它,因为innodb默认支持它)

-- 不同的存储引擎支持的索引类型也不一样

InnoDB 支持事务,支持行级别锁定,支持 B-tree、Full-text 等索引,不支持 Hash 索引;

MyISAM 不支持事务,支持表级别锁定,支持 B-tree、Full-text 等索引,不支持 Hash 索引;

Memory 不支持事务,支持表级别锁定,支持 B-tree、Hash 等索引,不支持 Full-text 索引;

NDB 支持事务,支持行级别锁定,支持 Hash 索引,不支持 B-tree、Full-text 等索引;

Archive 不支持事务,支持表级别锁定,不支持 B-tree、Hash、Full-text 等索引;权限及设计数据库

用户管理

使用SQLyog 创建用户,并授予权限演示

基本命令

/* 用户和权限管理 */ ------------------

用户信息表:mysql.user

-- 刷新权限

FLUSH PRIVILEGES

-- 增加用户 CREATE USER kuangshen IDENTIFIED BY '123456'

CREATE USER 用户名 IDENTIFIED BY [PASSWORD] 密码(字符串)

- 必须拥有mysql数据库的全局CREATE USER权限,或拥有INSERT权限。

- 只能创建用户,不能赋予权限。

- 用户名,注意引号:如 'user_name'@'192.168.1.1'

- 密码也需引号,纯数字密码也要加引号

- 要在纯文本中指定密码,需忽略PASSWORD关键词。要把密码指定为由PASSWORD()函数返回的混编值,需包含关键字PASSWORD

-- 重命名用户 RENAME USER kuangshen TO kuangshen2

RENAME USER old_user TO new_user

-- 设置密码

SET PASSWORD = PASSWORD('密码') -- 为当前用户设置密码

SET PASSWORD FOR 用户名 = PASSWORD('密码') -- 为指定用户设置密码

-- 删除用户 DROP USER kuangshen2

DROP USER 用户名

-- 分配权限/添加用户

GRANT 权限列表 ON 表名 TO 用户名 [IDENTIFIED BY [PASSWORD] 'password']

- all privileges 表示所有权限

- *.* 表示所有库的所有表

- 库名.表名 表示某库下面的某表

-- 查看权限 SHOW GRANTS FOR root@localhost;

SHOW GRANTS FOR 用户名

-- 查看当前用户权限

SHOW GRANTS; 或 SHOW GRANTS FOR CURRENT_USER; 或 SHOW GRANTS FOR CURRENT_USER();

-- 撤消权限

REVOKE 权限列表 ON 表名 FROM 用户名

REVOKE ALL PRIVILEGES, GRANT OPTION FROM 用户名 -- 撤销所有权限权限解释

-- 权限列表

ALL [PRIVILEGES] -- 设置除GRANT OPTION之外的所有简单权限

ALTER -- 允许使用ALTER TABLE

ALTER ROUTINE -- 更改或取消已存储的子程序

CREATE -- 允许使用CREATE TABLE

CREATE ROUTINE -- 创建已存储的子程序

CREATE TEMPORARY TABLES -- 允许使用CREATE TEMPORARY TABLE

CREATE USER -- 允许使用CREATE USER, DROP USER, RENAME USER和REVOKE ALL PRIVILEGES。

CREATE VIEW -- 允许使用CREATE VIEW

DELETE -- 允许使用DELETE

DROP -- 允许使用DROP TABLE

EXECUTE -- 允许用户运行已存储的子程序

FILE -- 允许使用SELECT...INTO OUTFILE和LOAD DATA INFILE

INDEX -- 允许使用CREATE INDEX和DROP INDEX

INSERT -- 允许使用INSERT

LOCK TABLES -- 允许对您拥有SELECT权限的表使用LOCK TABLES

PROCESS -- 允许使用SHOW FULL PROCESSLIST

REFERENCES -- 未被实施

RELOAD -- 允许使用FLUSH

REPLICATION CLIENT -- 允许用户询问从属服务器或主服务器的地址

REPLICATION SLAVE -- 用于复制型从属服务器(从主服务器中读取二进制日志事件)

SELECT -- 允许使用SELECT

SHOW DATABASES -- 显示所有数据库

SHOW VIEW -- 允许使用SHOW CREATE VIEW

SHUTDOWN -- 允许使用mysqladmin shutdown

SUPER -- 允许使用CHANGE MASTER, KILL, PURGE MASTER LOGS和SET GLOBAL语句,mysqladmin debug命令;允许您连接(一次),即使已达到max_connections。

UPDATE -- 允许使用UPDATE

USAGE -- “无权限”的同义词

GRANT OPTION -- 允许授予权限

/* 表维护 */

-- 分析和存储表的关键字分布

ANALYZE [LOCAL | NO_WRITE_TO_BINLOG] TABLE 表名 ...

-- 检查一个或多个表是否有错误

CHECK TABLE tbl_name [, tbl_name] ... [option] ...

option = {QUICK | FAST | MEDIUM | EXTENDED | CHANGED}

-- 整理数据文件的碎片

OPTIMIZE [LOCAL | NO_WRITE_TO_BINLOG] TABLE tbl_name [, tbl_name] ...MySQL备份

数据库备份必要性

- 保证重要数据不丢失

- 数据转移

MySQL数据库备份方法

- mysqldump备份工具

- 数据库管理工具,如SQLyog

- 直接拷贝数据库文件和相关配置文件

mysqldump客户端

作用 :

- 转储数据库

- 搜集数据库进行备份

- 将数据转移到另一个SQL服务器,不一定是MySQL服务器

-- 导出

1. 导出一张表 -- mysqldump -uroot -p123456 school student >D:/a.sql

mysqldump -u用户名 -p密码 库名 表名 > 文件名(D:/a.sql)

2. 导出多张表 -- mysqldump -uroot -p123456 school student result >D:/a.sql

mysqldump -u用户名 -p密码 库名 表1 表2 表3 > 文件名(D:/a.sql)

3. 导出所有表 -- mysqldump -uroot -p123456 school >D:/a.sql

mysqldump -u用户名 -p密码 库名 > 文件名(D:/a.sql)

4. 导出一个库 -- mysqldump -uroot -p123456 -B school >D:/a.sql

mysqldump -u用户名 -p密码 -B 库名 > 文件名(D:/a.sql)

可以-w携带备份条件

-- 导入

1. 在登录mysql的情况下:-- source D:/a.sql

source 备份文件

2. 在不登录的情况下

mysql -u用户名 -p密码 库名 < 备份文件规范化数据库设计

为什么需要数据库设计

当数据库比较复杂时我们需要设计数据库

糟糕的数据库设计 :

- 数据冗余,存储空间浪费

- 数据更新和插入的异常

- 程序性能差

良好的数据库设计 :

- 节省数据的存储空间

- 能够保证数据的完整性

- 方便进行数据库应用系统的开发

软件项目开发周期中数据库设计 :

- 需求分析阶段: 分析客户的业务和数据处理需求

- 概要设计阶段:设计数据库的E-R模型图 , 确认需求信息的正确和完整.

设计数据库步骤

收集信息

与该系统有关人员进行交流 , 座谈 , 充分了解用户需求 , 理解数据库需要完成的任务.

标识实体[Entity]

标识数据库要管理的关键对象或实体,实体一般是名词

标识每个实体需要存储的详细信息[Attribute]

标识实体之间的关系[Relationship]

三大范式

问题 : 为什么需要数据规范化?

不合规范的表设计会导致的问题:

信息重复

更新异常

插入异常

- 无法正确表示信息

删除异常

- 丢失有效信息

三大范式

第一范式 (1st NF)

第一范式的目标是确保每列的原子性,如果每列都是不可再分的最小数据单元,则满足第一范式 。简而言之,第一范式就是无重复的列。

第二范式(2nd NF)

第二范式(2NF)是在第一范式(1NF)的基础上建立起来的,即满足第二范式(2NF)必须先满足第一范式(1NF)。

第二范式要求每个表只描述一件事情

第三范式(3rd NF)

如果一个关系满足第二范式,并且除了主键以外的其他列都不传递依赖于主键列,则满足第三范式.

第三范式需要确保数据表中的每一列数据都和主键直接相关,而不能间接相关。

规范化和性能的关系

为满足某种商业目标 , 数据库性能比规范化数据库更重要

在数据规范化的同时 , 要综合考虑数据库的性能

通过在给定的表中添加额外的字段,以大量减少需要从中搜索信息所需的时间

通过在给定的表中插入计算列,以方便查询

数据库开发规范

基础规范

(1)必须使用InnoDB存储引擎解读:支持事务、行级锁、并发性能更好、CPU及内存缓存页优化使得资源利用率 更高

(2)必须使用UTF8字符集解读:万国码,无需转码,无乱码风险,节省空间

(3)数据表、数据字段必须加入中文注释解读:N年后谁知道这个r1,r2,r3字段是干嘛的

(4)禁止使用存储过程、视图、触发器、Event解读:高并发大数据的互联网业务,架构设计思路是“解放数据库 CPU,将计算转移到服 务层”,并发量大的情况下,这些功能很可能将数据库拖死,业务逻辑放到服务层具备更好 的扩展性,能够轻易实现“增机器就加性 能”。数据库擅长存储与索引,CPU计算还是上移吧

(5)禁止存储大文件或者大照片解读:为何要让数据库做它不擅长的事情?大文件和照片存储在文件系统,数据 库里存URI多好 命名规 范

(6)只允许使用内网域名,而不是ip连接数据库

(7)线上环境、开发环境、测试环境数据库内网域名遵循命名规范业务名称:xxx线上环境: my10000m.mysql.jddb.com开发环境: yf10000m.mysql.jddb.com测试环境:test10000m.mysql.jddb.com从 库在名称后加-s标识,备库在名称后加-ss标识线上从库: my10000sa.mysql.jddb.com

(8)库名、表名、字段名:小写,下划线风格,不超过32个字符,必须见名知意,禁止拼音英文混用

(9)表名t_xxx,非唯一索引名idx_xxx,唯一索引名uniq_xxx

(10)单实例表数目必须小于500

(11)单表列数目必须小于30

(12)表必须有主键,例如自增主键解读:

a)主键递增,数据行写入可以提高插入性能,可以避免page分裂,减少表碎片提升空间和内存的使用

b)主键要选择较短的数据类型, Innodb引擎普通索引都会保存主键的值,较短的数据类型可以有效的减少索引 的磁盘空间,提高 索引的缓存效率

c) 无主键的表删除,在row模式的主从架构,会导致备库夯住

(13)禁止使用外键,如果有外键完整性约束,需要应用程序控制解读:外键会导致表与表之间耦合,update与 delete操作都会涉及相 关联的表,十分影响sql 的性能,甚至会造成死锁。高并发情况下容易造成数据库性能,大 数据高并发业务场景数据库使用以性能优 先 字段设计规范

(14)必须把字段定义为NOT NULL并且提供默认值解读:

a)null的列使索引/索引统计/值比较都更加复杂,对MySQL来说更难优化

b)null 这种类型MySQL内部需要进行特殊处理,增加数据库处理记录的复杂性;同等条件下,表中有较多空字段 的时候,数据库 的处理性能会降低很多

c)null值需要更多的存储空,无论是表还是索引中每行中的null的列都需要额外的空间来标识

d)对null 的处理时候,只能采用is null或is not null,而不能采用=、in、<、<>、!=、not in这些操作符号。如: where name!=’shenjian’,如果存在name为null值的记录,查询结果就不会包含name为null值的记录

(15)禁止使用TEXT、BLOB类型解读:会浪费更多的磁盘和内存空间,非必要的大量的大字段查询会淘汰掉热数 据,导致内存命中率 急剧降低,影响数据库性能

(16)禁止使用小数存储货币解读,小数容易导致钱对不上

(17)必须使用varchar(20)存储手机号解读:

a)涉及到区号或者国家代号,可能出现+-()

b)手机号会去做数学运算么?

c)varchar可以支持模糊查询,例如:like“138%”

(18)禁止使用ENUM,可使用TINYINT代替解读:

a)增加新的ENUM值要做DDL操作

b)ENUM的内部实际存储 就是整数,你以为自己定义的是字符串?

(19)单表索引建议控制在5个以内 (20)单索引字段数不允许超过5个解读:字段超过5个时,实际已经起不到有效过滤数据的作用了 (21)禁止在更新十分频繁、区分度不高的属性上建立索引解读:

a)更新会变更B+树,更新频繁的字段建立索引 会大大降低数据库性能

b)“性别”这种区分度不大的属性,建立索引是没有什么意义的,不能有效过滤数据,性能 与全表扫描类似

(22)建立组合索引,必须把区分度高的字段放在前面解读:能够更加有效的过滤数据

(23)禁止使用SELECT *,只获取必要的字段,需要显示说明列属性解读:

a)读取不需要的列会增加CPU、IO、NET消耗

b)不能有效的利用覆盖索引

c)使用SELECT *容易在增加或者删除字段后出现程序BUG

(24)禁止使用INSERT INTO t_xxx VALUES(xxx),必须显示指定插入的列属性解读:容易在增加或者删除字段后 出现程序BUG

(25)禁止使用属性隐式转换解读:SELECT uid FROM t_user WHERE phone=13800000000 会导致全表扫描, 而不能命中phone索 引,猜猜为什么?(这个线上问题不止出现过一次)

(26)禁止在WHERE条件的属性上使用函数或者表达式解读:SELECT uid FROM t_user WHERE from_unixtime(day)>=’2017-01-15’ 会 导致全表扫描正确的写法是:SELECT uid FROM t_user WHERE day>= unix_timestamp(‘2017-01-15 00:00:00’)

(27)禁止负向查询,以及%开头的模糊查询解读: a)负向查询条件:NOT、!=、<>、!<、!>、NOT IN、NOT LIKE等,会导致全表扫 描 b)%开头的模糊查询,会导致全表扫描

(28)禁止使用JOIN查询,禁止大表使用子查询解读:会产生临时表,消耗较多内存与CPU,极大影响数据库性 能

(29)禁止使用OR条件,必须改为IN查询解读:旧版本Mysql的OR查询是不能命中索引的,即使能命中索引,为 何要让数据库耗费更多 的CPU帮助实施查询优化呢?

(30)应用程序必须捕获SQL异常,并有相应处理

(31)同表的增删字段、索引合并一条DDL语句执行,提高执行效率,减少与数据库的交互。

总结 大数据量高并发的互联网业务,极大影响数据库性能的都不让用,不让用哟

Mysql高级

MySQL高级-01

| 序号 | Day01 | Day02 | Day03 | Day04 |

|---|---|---|---|---|

| 1 | Linux系统安装MySQL | 体系结构 | 应用优化 | MySQL 常用工具 |

| 2 | 索引 | 存储引擎 | 查询缓存优化 | MySQL 日志 |

| 3 | 视图 | 优化SQL步骤 | 内存管理及优化 | MySQL 主从复制 |

| 4 | 存储过程和函数 | 索引使用 | MySQL锁问题 | 综合案例 |

| 5 | 触发器 | SQL优化 | 常用SQL技巧 |

1. Linux 系统安装MySQL

1.1 下载Linux 安装包

https://dev.mysql.com/downloads/mysql/5.7.html#downloads1.2 安装MySQL

1). 卸载 centos 中预安装的 mysql

rpm -qa | grep -i mysql

rpm -e mysql-libs-5.1.71-1.el6.x86_64 --nodeps

2). 上传 mysql 的安装包

alt + p -------> put E:/test/MySQL-5.6.22-1.el6.i686.rpm-bundle.tar

3). 解压 mysql 的安装包

mkdir mysql

tar -xvf MySQL-5.6.22-1.el6.i686.rpm-bundle.tar -C /root/mysql

4). 安装依赖包

yum -y install libaio.so.1 libgcc_s.so.1 libstdc++.so.6 libncurses.so.5 --setopt=protected_multilib=false

yum update libstdc++-4.4.7-4.el6.x86_64

5). 安装 mysql-client

rpm -ivh MySQL-client-5.6.22-1.el6.i686.rpm

6). 安装 mysql-server

rpm -ivh MySQL-server-5.6.22-1.el6.i686.rpm

1.3 启动 MySQL 服务

service mysql start

service mysql stop

service mysql status

service mysql restart1.4 登录MySQL

mysql 安装完成之后, 会自动生成一个随机的密码, 并且保存在一个密码文件中 : /root/.mysql_secret

mysql -u root -p

登录之后, 修改密码 :

set password = password('itcast');

授权远程访问 :

grant all privileges on *.* to 'root' @'%' identified by 'itcast';

flush privileges;

2. 索引

2.1 索引概述

MySQL官方对索引的定义为:索引(index)是帮助MySQL高效获取数据的数据结构(有序)。在数据之外,数据库系统还维护者满足特定查找算法的数据结构,这些数据结构以某种方式引用(指向)数据, 这样就可以在这些数据结构上实现高级查找算法,这种数据结构就是索引。如下面的==示意图==所示 :

左边是数据表,一共有两列七条记录,最左边的是数据记录的物理地址(注意逻辑上相邻的记录在磁盘上也并不是一定物理相邻的)。为了加快Col2的查找,可以维护一个右边所示的二叉查找树,每个节点分别包含索引键值和一个指向对应数据记录物理地址的指针,这样就可以运用二叉查找快速获取到相应数据。

一般来说索引本身也很大,不可能全部存储在内存中,因此索引往往以索引文件的形式存储在磁盘上。索引是数据库中用来提高性能的最常用的工具。

2.2 索引优势劣势

优势

1) 类似于书籍的目录索引,提高数据检索的效率,降低数据库的IO成本。

2) 通过索引列对数据进行排序,降低数据排序的成本,降低CPU的消耗。

劣势

1) 实际上索引也是一张表,该表中保存了主键与索引字段,并指向实体类的记录,所以索引列也是要占用空间的。

2) 虽然索引大大提高了查询效率,同时却也降低更新表的速度,如对表进行INSERT、UPDATE、DELETE。因为更新表时,MySQL 不仅要保存数据,还要保存一下索引文件每次更新添加了索引列的字段,都会调整因为更新所带来的键值变化后的索引信息。

2.3 索引结构

索引是在MySQL的存储引擎层中实现的,而不是在服务器层实现的。所以每种存储引擎的索引都不一定完全相同,也不是所有的存储引擎都支持所有的索引类型的。MySQL目前提供了以下4种索引:

- BTREE 索引 : 最常见的索引类型,大部分索引都支持 B 树索引。

- HASH 索引:只有Memory引擎支持 , 使用场景简单 。

- R-tree 索引(空间索引):空间索引是MyISAM引擎的一个特殊索引类型,主要用于地理空间数据类型,通常使用较少,不做特别介绍。

- Full-text (全文索引) :全文索引也是MyISAM的一个特殊索引类型,主要用于全文索引,InnoDB从Mysql5.6版本开始支持全文索引。

| 索引 | InnoDB引擎 | MyISAM引擎 | Memory引擎 |

|---|---|---|---|

| BTREE索引 | 支持 | 支持 | 支持 |

| HASH 索引 | 不支持 | 不支持 | 支持 |

| R-tree 索引 | 不支持 | 支持 | 不支持 |

| Full-text | 5.6版本之后支持 | 支持 | 不支持 |

我们平常所说的索引,如果没有特别指明,都是指B+树(多路搜索树,并不一定是二叉的)结构组织的索引。其中聚集索引、复合索引、前缀索引、唯一索引默认都是使用 B+tree 索引,统称为 索引。

2.3.1 BTREE 结构

BTree又叫多路平衡搜索树,一颗m叉的BTree特性如下:

- 树中每个节点最多包含m个孩子。

- 除根节点与叶子节点外,每个节点至少有[ceil(m/2)]个孩子。(ceil(2.5)=3,向上取整)

- 若根节点不是叶子节点,则至少有两个孩子。

- 所有的叶子节点都在同一层。

- 每个非叶子节点由n个key与n+1个指针组成,其中[ceil(m/2)-1] <= n <= m-1

以5叉BTree为例,key的数量:公式推导[ceil(m/2)-1] <= n <= m-1。所以 2 <= n <=4 。当n>4时,中间节点分裂到父节点,两边节点分裂。

插入 C N G A H E K Q M F W L T Z D P R X Y S 数据为例。

演变过程如下:

1). 插入前4个字母 C N G A

2). 插入H,n>4,中间元素G字母向上分裂到新的节点

3). 插入E,K,Q不需要分裂

4). 插入M,中间元素M字母向上分裂到父节点G

5). 插入F,W,L,T不需要分裂

6). 插入Z,中间元素T向上分裂到父节点中

7). 插入D,中间元素D向上分裂到父节点中。然后插入P,R,X,Y不需要分裂

8). 最后插入S,NPQR节点n>5,中间节点Q向上分裂,但分裂后父节点DGMT的n>5,中间节点M向上分裂

到此,该BTREE树就已经构建完成了, BTREE树 和 二叉树 相比, 查询数据的效率更高, 因为对于相同的数据量来说,BTREE的层级结构比二叉树小,因此搜索速度快。

2.3.3 B+TREE 结构

B+Tree为BTree的变种,B+Tree与BTree的区别为:

1). n叉B+Tree最多含有n个key,而BTree最多含有n-1个key。

2). B+Tree的叶子节点保存所有的key信息,依key大小顺序排列。

3). 所有的非叶子节点都可以看作是key的索引部分。

由于B+Tree只有叶子节点保存key信息,查询任何key都要从root走到叶子。所以B+Tree的查询效率更加稳定。

2.3.3 MySQL中的B+Tree

MySql索引数据结构对经典的B+Tree进行了优化。在原B+Tree的基础上,增加一个指向相邻叶子节点的链表指针,就形成了带有顺序指针的B+Tree,提高区间访问的性能。

MySQL中的 B+Tree 索引结构示意图:

2.4 索引分类

1) 单值索引 :即一个索引只包含单个列,一个表可以有多个单列索引

2) 唯一索引 :索引列的值必须唯一,但允许有空值

3) 复合索引 :即一个索引包含多个列

2.5 索引语法

索引在创建表的时候,可以同时创建, 也可以随时增加新的索引。

准备环境:

create database demo_01 default charset=utf8mb4;

use demo_01;

CREATE TABLE `city` (

`city_id` int(11) NOT NULL AUTO_INCREMENT,

`city_name` varchar(50) NOT NULL,

`country_id` int(11) NOT NULL,

PRIMARY KEY (`city_id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8;

CREATE TABLE `country` (

`country_id` int(11) NOT NULL AUTO_INCREMENT,

`country_name` varchar(100) NOT NULL,

PRIMARY KEY (`country_id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8;

insert into `city` (`city_id`, `city_name`, `country_id`) values(1,'西安',1);

insert into `city` (`city_id`, `city_name`, `country_id`) values(2,'NewYork',2);

insert into `city` (`city_id`, `city_name`, `country_id`) values(3,'北京',1);

insert into `city` (`city_id`, `city_name`, `country_id`) values(4,'上海',1);

insert into `country` (`country_id`, `country_name`) values(1,'China');

insert into `country` (`country_id`, `country_name`) values(2,'America');

insert into `country` (`country_id`, `country_name`) values(3,'Japan');

insert into `country` (`country_id`, `country_name`) values(4,'UK');2.5.1 创建索引

语法 :

CREATE [UNIQUE|FULLTEXT|SPATIAL] INDEX index_name

[USING index_type]

ON tbl_name(index_col_name,...)

index_col_name : column_name[(length)][ASC | DESC]示例 : 为city表中的city_name字段创建索引 ;

2.5.2 查看索引

语法:

show index from table_name;示例:查看city表中的索引信息;

2.5.3 删除索引

语法 :

DROP INDEX index_name ON tbl_name;示例 : 想要删除city表上的索引idx_city_name,可以操作如下:

2.5.4 ALTER命令

1). alter table tb_name add primary key(column_list);

该语句添加一个主键,这意味着索引值必须是唯一的,且不能为NULL

2). alter table tb_name add unique index_name(column_list);

这条语句创建索引的值必须是唯一的(除了NULL外,NULL可能会出现多次)

3). alter table tb_name add index index_name(column_list);

添加普通索引, 索引值可以出现多次。

4). alter table tb_name add fulltext index_name(column_list);

该语句指定了索引为FULLTEXT, 用于全文索引

2.6 索引设计原则

索引的设计可以遵循一些已有的原则,创建索引的时候请尽量考虑符合这些原则,便于提升索引的使用效率,更高效的使用索引。

对查询频次较高,且数据量比较大的表建立索引。

索引字段的选择,最佳候选列应当从where子句的条件中提取,如果where子句中的组合比较多,那么应当挑选最常用、过滤效果最好的列的组合。

使用唯一索引,区分度越高,使用索引的效率越高。

索引可以有效的提升查询数据的效率,但索引数量不是多多益善,索引越多,维护索引的代价自然也就水涨船高。对于插入、更新、删除等DML操作比较频繁的表来说,索引过多,会引入相当高的维护代价,降低DML操作的效率,增加相应操作的时间消耗。另外索引过多的话,MySQL也会犯选择困难病,虽然最终仍然会找到一个可用的索引,但无疑提高了选择的代价。

使用短索引,索引创建之后也是使用硬盘来存储的,因此提升索引访问的I/O效率,也可以提升总体的访问效率。假如构成索引的字段总长度比较短,那么在给定大小的存储块内可以存储更多的索引值,相应的可以有效的提升MySQL访问索引的I/O效率。

利用最左前缀,N个列组合而成的组合索引,那么相当于是创建了N个索引,如果查询时where子句中使用了组成该索引的前几个字段,那么这条查询SQL可以利用组合索引来提升查询效率。

创建复合索引: CREATE INDEX idx_name_email_status ON tb_seller(NAME,email,STATUS); 就相当于 对name 创建索引 ; 对name , email 创建了索引 ; 对name , email, status 创建了索引 ;

3. 视图

3.1 视图概述

视图(View)是一种虚拟存在的表。视图并不在数据库中实际存在,行和列数据来自定义视图的查询中使用的表,并且是在使用视图时动态生成的。通俗的讲,视图就是一条SELECT语句执行后返回的结果集。所以我们在创建视图的时候,主要的工作就落在创建这条SQL查询语句上。

视图相对于普通的表的优势主要包括以下几项。

- 简单:使用视图的用户完全不需要关心后面对应的表的结构、关联条件和筛选条件,对用户来说已经是过滤好的复合条件的结果集。

- 安全:使用视图的用户只能访问他们被允许查询的结果集,对表的权限管理并不能限制到某个行某个列,但是通过视图就可以简单的实现。

- 数据独立:一旦视图的结构确定了,可以屏蔽表结构变化对用户的影响,源表增加列对视图没有影响;源表修改列名,则可以通过修改视图来解决,不会造成对访问者的影响。

3.2 创建或者修改视图

创建视图的语法为:

CREATE [OR REPLACE] [ALGORITHM = {UNDEFINED | MERGE | TEMPTABLE}]

VIEW view_name [(column_list)]

AS select_statement

[WITH [CASCADED | LOCAL] CHECK OPTION]修改视图的语法为:

ALTER [ALGORITHM = {UNDEFINED | MERGE | TEMPTABLE}]

VIEW view_name [(column_list)]

AS select_statement

[WITH [CASCADED | LOCAL] CHECK OPTION]选项 :

WITH [CASCADED | LOCAL] CHECK OPTION 决定了是否允许更新数据使记录不再满足视图的条件。

LOCAL : 只要满足本视图的条件就可以更新。

CASCADED : 必须满足所有针对该视图的所有视图的条件才可以更新。 默认值.示例 , 创建city_country_view视图 , 执行如下SQL :

create or replace view city_country_view

as

select t.*,c.country_name from country c , city t where c.country_id = t.country_id;

查询视图 :

3.3 查看视图

从 MySQL 5.1 版本开始,使用 SHOW TABLES 命令的时候不仅显示表的名字,同时也会显示视图的名字,而不存在单独显示视图的 SHOW VIEWS 命令。

同样,在使用 SHOW TABLE STATUS 命令的时候,不但可以显示表的信息,同时也可以显示视图的信息。

如果需要查询某个视图的定义,可以使用 SHOW CREATE VIEW 命令进行查看 :

3.4 删除视图

语法 :

DROP VIEW [IF EXISTS] view_name [, view_name] ...[RESTRICT | CASCADE] 示例 , 删除视图city_country_view :

DROP VIEW city_country_view ;4. 存储过程和函数

4.1 存储过程和函数概述

存储过程和函数是 事先经过编译并存储在数据库中的一段 SQL 语句的集合,调用存储过程和函数可以简化应用开发人员的很多工作,减少数据在数据库和应用服务器之间的传输,对于提高数据处理的效率是有好处的。

存储过程和函数的区别在于函数必须有返回值,而存储过程没有。

函数 : 是一个有返回值的过程 ;

过程 : 是一个没有返回值的函数 ;

4.2 创建存储过程

CREATE PROCEDURE procedure_name ([proc_parameter[,...]])

begin

-- SQL语句

end ;示例 :

delimiter $

create procedure pro_test1()

begin

select 'Hello Mysql' ;

end$

delimiter ;知识小贴士

DELIMITER

该关键字用来声明SQL语句的分隔符 , 告诉 MySQL 解释器,该段命令是否已经结束了,mysql是否可以执行了。默认情况下,delimiter是分号;。在命令行客户端中,如果有一行命令以分号结束,那么回车后,mysql将会执行该命令。

4.3 调用存储过程

call procedure_name() ; 4.4 查看存储过程

-- 查询db_name数据库中的所有的存储过程

select name from mysql.proc where db='db_name';

-- 查询存储过程的状态信息

show procedure status;

-- 查询某个存储过程的定义

show create procedure test.pro_test1 \G;4.5 删除存储过程

DROP PROCEDURE [IF EXISTS] sp_name ;4.6 语法

存储过程是可以编程的,意味着可以使用变量,表达式,控制结构 , 来完成比较复杂的功能。

4.6.1 变量

DECLARE

通过 DECLARE 可以定义一个局部变量,该变量的作用范围只能在 BEGIN…END 块中。

DECLARE var_name[,...] type [DEFAULT value]示例 :

delimiter $

create procedure pro_test2()

begin

declare num int default 5;

select num+ 10;

end$

delimiter ; - SET

直接赋值使用 SET,可以赋常量或者赋表达式,具体语法如下:

SET var_name = expr [, var_name = expr] ...示例 :

DELIMITER $

CREATE PROCEDURE pro_test3()

BEGIN

DECLARE NAME VARCHAR(20);

SET NAME = 'MYSQL';

SELECT NAME ;

END$

DELIMITER ;也可以通过select … into 方式进行赋值操作 :

DELIMITER $

CREATE PROCEDURE pro_test5()

BEGIN

declare countnum int;

select count(*) into countnum from city;

select countnum;

END$

DELIMITER ;4.6.2 if条件判断

语法结构 :

if search_condition then statement_list

[elseif search_condition then statement_list] ...

[else statement_list]

end if;需求:

根据定义的身高变量,判定当前身高的所属的身材类型

180 及以上 ----------> 身材高挑

170 - 180 ---------> 标准身材

170 以下 ----------> 一般身材示例 :

delimiter $

create procedure pro_test6()

begin

declare height int default 175;

declare description varchar(50);

if height >= 180 then

set description = '身材高挑';

elseif height >= 170 and height < 180 then

set description = '标准身材';

else

set description = '一般身材';

end if;

select description ;

end$

delimiter ;调用结果为 :

4.6.3 传递参数

语法格式 :

create procedure procedure_name([in/out/inout] 参数名 参数类型)

...

IN : 该参数可以作为输入,也就是需要调用方传入值 , 默认

OUT: 该参数作为输出,也就是该参数可以作为返回值

INOUT: 既可以作为输入参数,也可以作为输出参数IN - 输入

需求 :

根据定义的身高变量,判定当前身高的所属的身材类型 示例 :

delimiter $

create procedure pro_test5(in height int)

begin

declare description varchar(50) default '';

if height >= 180 then

set description='身材高挑';

elseif height >= 170 and height < 180 then

set description='标准身材';

else

set description='一般身材';

end if;

select concat('身高 ', height , '对应的身材类型为:',description);

end$

delimiter ;OUT-输出

需求 :

根据传入的身高变量,获取当前身高的所属的身材类型 示例:

create procedure pro_test5(in height int , out description varchar(100))

begin

if height >= 180 then

set description='身材高挑';

elseif height >= 170 and height < 180 then

set description='标准身材';

else

set description='一般身材';

end if;

end$ 调用:

call pro_test5(168, @description)$

select @description$小知识

@description : 这种变量要在变量名称前面加上“@”符号,叫做用户会话变量,代表整个会话过程他都是有作用的,这个类似于全局变量一样。

@@global.sort_buffer_size : 这种在变量前加上 “@@” 符号, 叫做 系统变量

4.6.4 case结构

语法结构 :

方式一 :

CASE case_value

WHEN when_value THEN statement_list

[WHEN when_value THEN statement_list] ...

[ELSE statement_list]

END CASE;

方式二 :

CASE

WHEN search_condition THEN statement_list

[WHEN search_condition THEN statement_list] ...

[ELSE statement_list]

END CASE;

需求:

给定一个月份, 然后计算出所在的季度示例 :

delimiter $

create procedure pro_test9(month int)

begin

declare result varchar(20);

case

when month >= 1 and month <=3 then

set result = '第一季度';

when month >= 4 and month <=6 then

set result = '第二季度';

when month >= 7 and month <=9 then

set result = '第三季度';

when month >= 10 and month <=12 then

set result = '第四季度';

end case;

select concat('您输入的月份为 :', month , ' , 该月份为 : ' , result) as content ;

end$

delimiter ;4.6.5 while循环

语法结构:

while search_condition do

statement_list

end while;需求:

计算从1加到n的值示例 :

delimiter $

create procedure pro_test8(n int)

begin

declare total int default 0;

declare num int default 1;

while num<=n do

set total = total + num;

set num = num + 1;

end while;

select total;

end$

delimiter ;4.6.6 repeat结构

有条件的循环控制语句, 当满足条件的时候退出循环 。while 是满足条件才执行,repeat 是满足条件就退出循环。

语法结构 :

REPEAT

statement_list

UNTIL search_condition

END REPEAT;需求:

计算从1加到n的值示例 :

delimiter $

create procedure pro_test10(n int)

begin

declare total int default 0;

repeat

set total = total + n;

set n = n - 1;

until n=0

end repeat;

select total ;

end$

delimiter ;4.6.7 loop语句

LOOP 实现简单的循环,退出循环的条件需要使用其他的语句定义,通常可以使用 LEAVE 语句实现,具体语法如下:

[begin_label:] LOOP

statement_list

END LOOP [end_label]如果不在 statement_list 中增加退出循环的语句,那么 LOOP 语句可以用来实现简单的死循环。

4.6.8 leave语句

用来从标注的流程构造中退出,通常和 BEGIN … END 或者循环一起使用。下面是一个使用 LOOP 和 LEAVE 的简单例子 , 退出循环:

delimiter $

CREATE PROCEDURE pro_test11(n int)

BEGIN

declare total int default 0;

ins: LOOP

IF n <= 0 then

leave ins;

END IF;

set total = total + n;

set n = n - 1;

END LOOP ins;

select total;

END$

delimiter ;4.6.9 游标/光标

游标是用来存储查询结果集的数据类型 , 在存储过程和函数中可以使用光标对结果集进行循环的处理。光标的使用包括光标的声明、OPEN、FETCH 和 CLOSE,其语法分别如下。

声明光标:

DECLARE cursor_name CURSOR FOR select_statement ;OPEN 光标:

OPEN cursor_name ;FETCH 光标:

FETCH cursor_name INTO var_name [, var_name] ...CLOSE 光标:

CLOSE cursor_name ;示例 :

初始化脚本:

create table emp(

id int(11) not null auto_increment ,

name varchar(50) not null comment '姓名',

age int(11) comment '年龄',

salary int(11) comment '薪水',

primary key(`id`)

)engine=innodb default charset=utf8 ;

insert into emp(id,name,age,salary) values(null,'金毛狮王',55,3800),(null,'白眉鹰王',60,4000),(null,'青翼蝠王',38,2800),(null,'紫衫龙王',42,1800);

-- 查询emp表中数据, 并逐行获取进行展示

create procedure pro_test11()

begin

declare e_id int(11);

declare e_name varchar(50);

declare e_age int(11);

declare e_salary int(11);

declare emp_result cursor for select * from emp;

open emp_result;

fetch emp_result into e_id,e_name,e_age,e_salary;

select concat('id=',e_id , ', name=',e_name, ', age=', e_age, ', 薪资为: ',e_salary);

fetch emp_result into e_id,e_name,e_age,e_salary;

select concat('id=',e_id , ', name=',e_name, ', age=', e_age, ', 薪资为: ',e_salary);

fetch emp_result into e_id,e_name,e_age,e_salary;

select concat('id=',e_id , ', name=',e_name, ', age=', e_age, ', 薪资为: ',e_salary);

fetch emp_result into e_id,e_name,e_age,e_salary;

select concat('id=',e_id , ', name=',e_name, ', age=', e_age, ', 薪资为: ',e_salary);

fetch emp_result into e_id,e_name,e_age,e_salary;

select concat('id=',e_id , ', name=',e_name, ', age=', e_age, ', 薪资为: ',e_salary);

close emp_result;

end$

通过循环结构 , 获取游标中的数据 :

DELIMITER $

create procedure pro_test12()

begin

DECLARE id int(11);

DECLARE name varchar(50);

DECLARE age int(11);

DECLARE salary int(11);

DECLARE has_data int default 1;

DECLARE emp_result CURSOR FOR select * from emp;

DECLARE EXIT HANDLER FOR NOT FOUND set has_data = 0;

open emp_result;

repeat

fetch emp_result into id , name , age , salary;

select concat('id为',id, ', name 为' ,name , ', age为 ' ,age , ', 薪水为: ', salary);

until has_data = 0

end repeat;

close emp_result;

end$

DELIMITER ; 4.7 存储函数

语法结构:

CREATE FUNCTION function_name([param type ... ])

RETURNS type

BEGIN

...

END;案例 :

定义一个存储过程, 请求满足条件的总记录数 ;

delimiter $

create function count_city(countryId int)

returns int

begin

declare cnum int ;

select count(*) into cnum from city where country_id = countryId;

return cnum;

end$

delimiter ;调用:

select count_city(1);

select count_city(2);5. 触发器

5.1 介绍

触发器是与表有关的数据库对象,指在 insert/update/delete 之前或之后,触发并执行触发器中定义的SQL语句集合。触发器的这种特性可以协助应用在数据库端确保数据的完整性 , 日志记录 , 数据校验等操作 。

使用别名 OLD 和 NEW 来引用触发器中发生变化的记录内容,这与其他的数据库是相似的。现在触发器还只支持行级触发,不支持语句级触发。

| 触发器类型 | NEW 和 OLD的使用 |

|---|---|

| INSERT 型触发器 | NEW 表示将要或者已经新增的数据 |

| UPDATE 型触发器 | OLD 表示修改之前的数据 , NEW 表示将要或已经修改后的数据 |

| DELETE 型触发器 | OLD 表示将要或者已经删除的数据 |

5.2 创建触发器

语法结构 :

create trigger trigger_name

before/after insert/update/delete

on tbl_name

[ for each row ] -- 行级触发器

begin

trigger_stmt ;

end;示例

需求

通过触发器记录 emp 表的数据变更日志 , 包含增加, 修改 , 删除 ;首先创建一张日志表 :

create table emp_logs(

id int(11) not null auto_increment,

operation varchar(20) not null comment '操作类型, insert/update/delete',

operate_time datetime not null comment '操作时间',

operate_id int(11) not null comment '操作表的ID',

operate_params varchar(500) comment '操作参数',

primary key(`id`)

)engine=innodb default charset=utf8;创建 insert 型触发器,完成插入数据时的日志记录 :

DELIMITER $

create trigger emp_logs_insert_trigger

after insert

on emp

for each row

begin

insert into emp_logs (id,operation,operate_time,operate_id,operate_params) values(null,'insert',now(),new.id,concat('插入后(id:',new.id,', name:',new.name,', age:',new.age,', salary:',new.salary,')'));

end $

DELIMITER ;创建 update 型触发器,完成更新数据时的日志记录 :

DELIMITER $

create trigger emp_logs_update_trigger

after update

on emp

for each row

begin

insert into emp_logs (id,operation,operate_time,operate_id,operate_params) values(null,'update',now(),new.id,concat('修改前(id:',old.id,', name:',old.name,', age:',old.age,', salary:',old.salary,') , 修改后(id',new.id, 'name:',new.name,', age:',new.age,', salary:',new.salary,')'));

end $

DELIMITER ;创建delete 行的触发器 , 完成删除数据时的日志记录 :

DELIMITER $

create trigger emp_logs_delete_trigger

after delete

on emp

for each row

begin

insert into emp_logs (id,operation,operate_time,operate_id,operate_params) values(null,'delete',now(),old.id,concat('删除前(id:',old.id,', name:',old.name,', age:',old.age,', salary:',old.salary,')'));

end $

DELIMITER ;测试:

insert into emp(id,name,age,salary) values(null, '光明左使',30,3500);

insert into emp(id,name,age,salary) values(null, '光明右使',33,3200);

update emp set age = 39 where id = 3;

delete from emp where id = 5;5.3 删除触发器

语法结构 :

drop trigger [schema_name.]trigger_name如果没有指定 schema_name,默认为当前数据库 。

5.4 查看触发器

可以通过执行 SHOW TRIGGERS 命令查看触发器的状态、语法等信息。

语法结构 :

show triggers ;MySQL高级-02

1. Mysql的体系结构概览

整个MySQL Server由以下组成

- Connection Pool : 连接池组件

- Management Services & Utilities : 管理服务和工具组件

- SQL Interface : SQL接口组件

- Parser : 查询分析器组件

- Optimizer : 优化器组件

- Caches & Buffers : 缓冲池组件

- Pluggable Storage Engines : 存储引擎

- File System : 文件系统

1) 连接层

最上层是一些客户端和链接服务,包含本地sock 通信和大多数基于客户端/服务端工具实现的类似于 TCP/IP的通信。主要完成一些类似于连接处理、授权认证、及相关的安全方案。在该层上引入了线程池的概念,为通过认证安全接入的客户端提供线程。同样在该层上可以实现基于SSL的安全链接。服务器也会为安全接入的每个客户端验证它所具有的操作权限。

2) 服务层

第二层架构主要完成大多数的核心服务功能,如SQL接口,并完成缓存的查询,SQL的分析和优化,部分内置函数的执行。所有跨存储引擎的功能也在这一层实现,如 过程、函数等。在该层,服务器会解析查询并创建相应的内部解析树,并对其完成相应的优化如确定表的查询的顺序,是否利用索引等, 最后生成相应的执行操作。如果是select语句,服务器还会查询内部的缓存,如果缓存空间足够大,这样在解决大量读操作的环境中能够很好的提升系统的性能。

3) 引擎层

存储引擎层, 存储引擎真正的负责了MySQL中数据的存储和提取,服务器通过API和存储引擎进行通信。不同的存储引擎具有不同的功能,这样我们可以根据自己的需要,来选取合适的存储引擎。

4)存储层

数据存储层, 主要是将数据存储在文件系统之上,并完成与存储引擎的交互。

和其他数据库相比,MySQL有点与众不同,它的架构可以在多种不同场景中应用并发挥良好作用。主要体现在存储引擎上,插件式的存储引擎架构,将查询处理和其他的系统任务以及数据的存储提取分离。这种架构可以根据业务的需求和实际需要选择合适的存储引擎。

2. 存储引擎

2.1 存储引擎概述

和大多数的数据库不同, MySQL中有一个存储引擎的概念, 针对不同的存储需求可以选择最优的存储引擎。

存储引擎就是存储数据,建立索引,更新查询数据等等技术的实现方式 。存储引擎是基于表的,而不是基于库的。所以存储引擎也可被称为表类型。

Oracle,SqlServer等数据库只有一种存储引擎。MySQL提供了插件式的存储引擎架构。所以MySQL存在多种存储引擎,可以根据需要使用相应引擎,或者编写存储引擎。

MySQL5.0支持的存储引擎包含 : InnoDB 、MyISAM 、BDB、MEMORY、MERGE、EXAMPLE、NDB Cluster、ARCHIVE、CSV、BLACKHOLE、FEDERATED等,其中InnoDB和BDB提供事务安全表,其他存储引擎是非事务安全表。

可以通过指定 show engines , 来查询当前数据库支持的存储引擎 :

创建新表时如果不指定存储引擎,那么系统就会使用默认的存储引擎,MySQL5.5之前的默认存储引擎是MyISAM,5.5之后就改为了InnoDB。

查看Mysql数据库默认的存储引擎 , 指令 :

show variables like '%storage_engine%' ;

2.2 各种存储引擎特性

下面重点介绍几种常用的存储引擎, 并对比各个存储引擎之间的区别, 如下表所示 :

| 特点 | InnoDB | MyISAM | MEMORY | MERGE | NDB |

|---|---|---|---|---|---|

| 存储限制 | 64TB | 有 | 有 | 没有 | 有 |

| 事务安全 | ==支持== | ||||

| 锁机制 | ==行锁(适合高并发)== | ==表锁== | 表锁 | 表锁 | 行锁 |

| B树索引 | 支持 | 支持 | 支持 | 支持 | 支持 |

| 哈希索引 | 支持 | ||||

| 全文索引 | 支持(5.6版本之后) | 支持 | |||

| 集群索引 | 支持 | ||||

| 数据索引 | 支持 | 支持 | 支持 | ||

| 索引缓存 | 支持 | 支持 | 支持 | 支持 | 支持 |

| 数据可压缩 | 支持 | ||||

| 空间使用 | 高 | 低 | N/A | 低 | 低 |

| 内存使用 | 高 | 低 | 中等 | 低 | 高 |

| 批量插入速度 | 低 | 高 | 高 | 高 | 高 |

| 支持外键 | ==支持== |

下面我们将重点介绍最长使用的两种存储引擎: InnoDB、MyISAM , 另外两种 MEMORY、MERGE , 了解即可。

2.2.1 InnoDB

InnoDB存储引擎是Mysql的默认存储引擎。InnoDB存储引擎提供了具有提交、回滚、崩溃恢复能力的事务安全。但是对比MyISAM的存储引擎,InnoDB写的处理效率差一些,并且会占用更多的磁盘空间以保留数据和索引。

InnoDB存储引擎不同于其他存储引擎的特点 :

事务控制

create table goods_innodb(

id int NOT NULL AUTO_INCREMENT,

name varchar(20) NOT NULL,

primary key(id)

)ENGINE=innodb DEFAULT CHARSET=utf8;start transaction;

insert into goods_innodb(id,name)values(null,'Meta20');

commit;

测试,发现在InnoDB中是存在事务的 ;

外键约束

MySQL支持外键的存储引擎只有InnoDB , 在创建外键的时候, 要求父表必须有对应的索引 , 子表在创建外键的时候, 也会自动的创建对应的索引。

下面两张表中 , country_innodb是父表 , country_id为主键索引,city_innodb表是子表,country_id字段为外键,对应于country_innodb表的主键country_id 。

create table country_innodb(

country_id int NOT NULL AUTO_INCREMENT,

country_name varchar(100) NOT NULL,

primary key(country_id)

)ENGINE=InnoDB DEFAULT CHARSET=utf8;

create table city_innodb(

city_id int NOT NULL AUTO_INCREMENT,

city_name varchar(50) NOT NULL,

country_id int NOT NULL,

primary key(city_id),

key idx_fk_country_id(country_id),

CONSTRAINT `fk_city_country` FOREIGN KEY(country_id) REFERENCES country_innodb(country_id) ON DELETE RESTRICT ON UPDATE CASCADE

)ENGINE=InnoDB DEFAULT CHARSET=utf8;

insert into country_innodb values(null,'China'),(null,'America'),(null,'Japan');

insert into city_innodb values(null,'Xian',1),(null,'NewYork',2),(null,'BeiJing',1);

在创建索引时, 可以指定在删除、更新父表时,对子表进行的相应操作,包括 RESTRICT、CASCADE、SET NULL 和 NO ACTION。

RESTRICT和NO ACTION相同, 是指限制在子表有关联记录的情况下, 父表不能更新;

CASCADE表示父表在更新或者删除时,更新或者删除子表对应的记录;

SET NULL 则表示父表在更新或者删除的时候,子表的对应字段被SET NULL 。

针对上面创建的两个表, 子表的外键指定是ON DELETE RESTRICT ON UPDATE CASCADE 方式的, 那么在主表删除记录的时候, 如果子表有对应记录, 则不允许删除, 主表在更新记录的时候, 如果子表有对应记录, 则子表对应更新 。

表中数据如下图所示 :

外键信息可以使用如下两种方式查看 :

show create table city_innodb ;

删除country_id为1 的country数据:

delete from country_innodb where country_id = 1;

更新主表country表的字段 country_id :

update country_innodb set country_id = 100 where country_id = 1;

更新后, 子表的数据信息为 :

存储方式

InnoDB 存储表和索引有以下两种方式 :

①. 使用共享表空间存储, 这种方式创建的表的表结构保存在.frm文件中, 数据和索引保存在 innodb_data_home_dir 和 innodb_data_file_path定义的表空间中,可以是多个文件。

②. 使用多表空间存储, 这种方式创建的表的表结构仍然存在 .frm 文件中,但是每个表的数据和索引单独保存在 .ibd 中。

2.2.2 MyISAM

MyISAM 不支持事务、也不支持外键,其优势是访问的速度快,对事务的完整性没有要求或者以SELECT、INSERT为主的应用基本上都可以使用这个引擎来创建表 。有以下两个比较重要的特点:

不支持事务

create table goods_myisam(

id int NOT NULL AUTO_INCREMENT,

name varchar(20) NOT NULL,

primary key(id)

)ENGINE=myisam DEFAULT CHARSET=utf8;

通过测试,我们发现,在MyISAM存储引擎中,是没有事务控制的 ;

文件存储方式

每个MyISAM在磁盘上存储成3个文件,其文件名都和表名相同,但拓展名分别是 :

.frm (存储表定义);

.MYD(MYData , 存储数据);

.MYI(MYIndex , 存储索引);

2.2.3 MEMORY

Memory存储引擎将表的数据存放在内存中。每个MEMORY表实际对应一个磁盘文件,格式是.frm ,该文件中只存储表的结构,而其数据文件,都是存储在内存中,这样有利于数据的快速处理,提高整个表的效率。MEMORY 类型的表访问非常地快,因为他的数据是存放在内存中的,并且默认使用HASH索引 , 但是服务一旦关闭,表中的数据就会丢失。

2.2.4 MERGE

MERGE存储引擎是一组MyISAM表的组合,这些MyISAM表必须结构完全相同,MERGE表本身并没有存储数据,对MERGE类型的表可以进行查询、更新、删除操作,这些操作实际上是对内部的MyISAM表进行的。

对于MERGE类型表的插入操作,是通过INSERT_METHOD子句定义插入的表,可以有3个不同的值,使用FIRST 或 LAST 值使得插入操作被相应地作用在第一或者最后一个表上,不定义这个子句或者定义为NO,表示不能对这个MERGE表执行插入操作。

可以对MERGE表进行DROP操作,但是这个操作只是删除MERGE表的定义,对内部的表是没有任何影响的。

下面是一个创建和使用MERGE表的示例 :

1). 创建3个测试表 order_1990, order_1991, order_all , 其中order_all是前两个表的MERGE表 :

create table order_1990(

order_id int ,

order_money double(10,2),

order_address varchar(50),

primary key (order_id)

)engine = myisam default charset=utf8;

create table order_1991(

order_id int ,

order_money double(10,2),

order_address varchar(50),

primary key (order_id)

)engine = myisam default charset=utf8;

create table order_all(

order_id int ,

order_money double(10,2),

order_address varchar(50),

primary key (order_id)

)engine = merge union = (order_1990,order_1991) INSERT_METHOD=LAST default charset=utf8;

2). 分别向两张表中插入记录

insert into order_1990 values(1,100.0,'北京');

insert into order_1990 values(2,100.0,'上海');

insert into order_1991 values(10,200.0,'北京');

insert into order_1991 values(11,200.0,'上海');3). 查询3张表中的数据。

order_1990中的数据 :

order_1991中的数据 :

order_all中的数据 :

4). 往order_all中插入一条记录 ,由于在MERGE表定义时,INSERT_METHOD 选择的是LAST,那么插入的数据会想最后一张表中插入。

insert into order_all values(100,10000.0,'西安');

2.3 存储引擎的选择

在选择存储引擎时,应该根据应用系统的特点选择合适的存储引擎。对于复杂的应用系统,还可以根据实际情况选择多种存储引擎进行组合。以下是几种常用的存储引擎的使用环境。

- InnoDB : 是Mysql的默认存储引擎,用于事务处理应用程序,支持外键。如果应用对事务的完整性有比较高的要求,在并发条件下要求数据的一致性,数据操作除了插入和查询意外,还包含很多的更新、删除操作,那么InnoDB存储引擎是比较合适的选择。InnoDB存储引擎除了有效的降低由于删除和更新导致的锁定, 还可以确保事务的完整提交和回滚,对于类似于计费系统或者财务系统等对数据准确性要求比较高的系统,InnoDB是最合适的选择。

- MyISAM : 如果应用是以读操作和插入操作为主,只有很少的更新和删除操作,并且对事务的完整性、并发性要求不是很高,那么选择这个存储引擎是非常合适的。

- MEMORY:将所有数据保存在RAM中,在需要快速定位记录和其他类似数据环境下,可以提供几块的访问。MEMORY的缺陷就是对表的大小有限制,太大的表无法缓存在内存中,其次是要确保表的数据可以恢复,数据库异常终止后表中的数据是可以恢复的。MEMORY表通常用于更新不太频繁的小表,用以快速得到访问结果。

- MERGE:用于将一系列等同的MyISAM表以逻辑方式组合在一起,并作为一个对象引用他们。MERGE表的优点在于可以突破对单个MyISAM表的大小限制,并且通过将不同的表分布在多个磁盘上,可以有效的改善MERGE表的访问效率。这对于存储诸如数据仓储等VLDB环境十分合适。

3. 优化SQL步骤

在应用的的开发过程中,由于初期数据量小,开发人员写 SQL 语句时更重视功能上的实现,但是当应用系统正式上线后,随着生产数据量的急剧增长,很多 SQL 语句开始逐渐显露出性能问题,对生产的影响也越来越大,此时这些有问题的 SQL 语句就成为整个系统性能的瓶颈,因此我们必须要对它们进行优化,本章将详细介绍在 MySQL 中优化 SQL 语句的方法。

当面对一个有 SQL 性能问题的数据库时,我们应该从何处入手来进行系统的分析,使得能够尽快定位问题 SQL 并尽快解决问题。

3.1 查看SQL执行频率

MySQL 客户端连接成功后,通过 show [session|global] status 命令可以提供服务器状态信息。show [session|global] status 可以根据需要加上参数“session”或者“global”来显示 session 级(当前连接)的计结果和 global 级(自数据库上次启动至今)的统计结果。如果不写,默认使用参数是“session”。

下面的命令显示了当前 session 中所有统计参数的值:

show status like 'Com_______';

show status like 'Innodb_rows_%';

Com_xxx 表示每个 xxx 语句执行的次数,我们通常比较关心的是以下几个统计参数。

| 参数 | 含义 |

|---|---|

| Com_select | 执行 select 操作的次数,一次查询只累加 1。 |

| Com_insert | 执行 INSERT 操作的次数,对于批量插入的 INSERT 操作,只累加一次。 |

| Com_update | 执行 UPDATE 操作的次数。 |

| Com_delete | 执行 DELETE 操作的次数。 |

| Innodb_rows_read | select 查询返回的行数。 |

| Innodb_rows_inserted | 执行 INSERT 操作插入的行数。 |

| Innodb_rows_updated | 执行 UPDATE 操作更新的行数。 |

| Innodb_rows_deleted | 执行 DELETE 操作删除的行数。 |

| Connections | 试图连接 MySQL 服务器的次数。 |

| Uptime | 服务器工作时间。 |

| Slow_queries | 慢查询的次数。 |

Com_*** : 这些参数对于所有存储引擎的表操作都会进行累计。

Innodb_*** : 这几个参数只是针对InnoDB 存储引擎的,累加的算法也略有不同。

3.2 定位低效率执行SQL

可以通过以下两种方式定位执行效率较低的 SQL 语句。

- 慢查询日志 : 通过慢查询日志定位那些执行效率较低的 SQL 语句,用–log-slow-queries[=file_name]选项启动时,mysqld 写一个包含所有执行时间超过 long_query_time 秒的 SQL 语句的日志文件。具体可以查看本书第 26 章中日志管理的相关部分。

- show processlist : 慢查询日志在查询结束以后才纪录,所以在应用反映执行效率出现问题的时候查询慢查询日志并不能定位问题,可以使用show processlist命令查看当前MySQL在进行的线程,包括线程的状态、是否锁表等,可以实时地查看 SQL 的执行情况,同时对一些锁表操作进行优化。

1) id列,用户登录mysql时,系统分配的"connection_id",可以使用函数connection_id()查看

2) user列,显示当前用户。如果不是root,这个命令就只显示用户权限范围的sql语句

3) host列,显示这个语句是从哪个ip的哪个端口上发的,可以用来跟踪出现问题语句的用户

4) db列,显示这个进程目前连接的是哪个数据库

5) command列,显示当前连接的执行的命令,一般取值为休眠(sleep),查询(query),连接(connect)等

6) time列,显示这个状态持续的时间,单位是秒

7) state列,显示使用当前连接的sql语句的状态,很重要的列。state描述的是语句执行中的某一个状态。一个sql语句,以查询为例,可能需要经过copying to tmp table、sorting result、sending data等状态才可以完成

8) info列,显示这个sql语句,是判断问题语句的一个重要依据3.3 explain分析执行计划

通过以上步骤查询到效率低的 SQL 语句后,可以通过 EXPLAIN或者 DESC命令获取 MySQL如何执行 SELECT 语句的信息,包括在 SELECT 语句执行过程中表如何连接和连接的顺序。

查询SQL语句的执行计划 :

explain select * from tb_item where id = 1;

explain select * from tb_item where title = '阿尔卡特 (OT-979) 冰川白 联通3G手机3';

| 字段 | 含义 |

|---|---|

| id | select查询的序列号,是一组数字,表示的是查询中执行select子句或者是操作表的顺序。 |

| select_type | 表示 SELECT 的类型,常见的取值有 SIMPLE(简单表,即不使用表连接或者子查询)、PRIMARY(主查询,即外层的查询)、UNION(UNION 中的第二个或者后面的查询语句)、SUBQUERY(子查询中的第一个 SELECT)等 |

| table | 输出结果集的表 |

| type | 表示表的连接类型,性能由好到差的连接类型为( system —> const —–> eq_ref ——> ref ——-> ref_or_null—-> index_merge —> index_subquery —–> range —–> index ——> all ) |

| possible_keys | 表示查询时,可能使用的索引 |

| key | 表示实际使用的索引 |

| key_len | 索引字段的长度 |

| rows | 扫描行的数量 |

| extra | 执行情况的说明和描述 |

3.3.1 环境准备

CREATE TABLE `t_role` (

`id` varchar(32) NOT NULL,

`role_name` varchar(255) DEFAULT NULL,

`role_code` varchar(255) DEFAULT NULL,

`description` varchar(255) DEFAULT NULL,

PRIMARY KEY (`id`),

UNIQUE KEY `unique_role_name` (`role_name`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8;

CREATE TABLE `t_user` (

`id` varchar(32) NOT NULL,

`username` varchar(45) NOT NULL,

`password` varchar(96) NOT NULL,

`name` varchar(45) NOT NULL,

PRIMARY KEY (`id`),

UNIQUE KEY `unique_user_username` (`username`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8;

CREATE TABLE `user_role` (

`id` int(11) NOT NULL auto_increment ,

`user_id` varchar(32) DEFAULT NULL,

`role_id` varchar(32) DEFAULT NULL,

PRIMARY KEY (`id`),

KEY `fk_ur_user_id` (`user_id`),

KEY `fk_ur_role_id` (`role_id`),